2. 中北大学 信息探测与处理山西省重点实验室, 太原 030051

2. Shanxi Provincial Key Laboratory of Information Detection and Processing, North University of China, Taiyuan 030051, China

光场是指空间中每一个点通过各个方向的光量, 是包含了光的位置和方向信息的四维光辐射场的参数化表示[1, 2], 通常用一组在空间中稠密采样的图像序列表示, 称为光场图像. 光场图像可以通过相机阵列[3]、非结构化方法[4]和孔径编码成像[5]进行获取, 相比于传统的2D成像方式, 其多出了位置和方向信息2个自由度, 这在计算成像中有很广的应用[6]. 基于光场图像信息的深度重建是指从获取的光场序列图像中提取有用的深度信息, 且这些信息包含了丰富的位置和方向信息, 所以在处理图像亮度变化较大和弱纹理区域可以得到很好的重建效果, 尤其是在光场图像的深度估计中[7].

深度图像估计的准确性是深度重建的基础, 在光场中, 较多的光场视图数量对于获得准确和稠密深度图仍是一个很大的挑战. 为了得到准确和可靠的深度图, 许多具有代表性的方法已被采用. 传统的立体匹配是一个很重要的研究方向[8], 通过两幅图或者是多幅图之间像素点的对应关系, 获得场景的深度信息, 但这些方法在处理弱纹理区和有遮挡区, 效果很差, 鲁棒性低[9]. Bolles等人[10]提出了极平面图像(ExtremePlane Image, EPI)的概念, 根据EPI的线性特点, 拟合直线后计算斜率达到估计深度的目的, 得到了较好的深度图. Criminisi等[11]采用分层思想, 利用迭代优化方法将EPI分成不同深度的EPI-tube, 通过对3D光场的反射特性进行分类, 可以去除EPI-tube中由镜面反射造成的影响, 得到较好的效果, 但是其算法的复杂度较高, 比较费时. Kim等[12]提出由精到粗的深度扩散方法: 首先根据边缘置信度, 计算场景的边缘轮廓信息; 再依次通过降采样来计算轮廓内部的深度, 但是对于较小视差的估计, 精确度比较低. 丁伟利[13]等提出了一种改进的Kim算法进行视差的估计: 采用交叉检测模型检测边缘进行视差的估计, 引入了权值的计算, 但其算法没有解决较小视差估计不精确的问题. Wanner等[14-16]提出了结构张量的方法获取EPI中的斜率进而求得视差, 采用全局优化的方法将结果整合到深度图中, 结果虽然较为平滑, 但是边缘信息丢失严重. Tao等人[17]提出了一种同时结合散焦和对应深度融合的方法估计深度, 根据在不同焦栈处的模糊程度, 来得到其对应的深度, 然而, 对于离主透镜焦平面比较远的区域, 深度估计误差较大.

针对上述问题, 本文提出了一种改进的基于CIELab颜色空间、梯度和距离的自适应权值块匹配深度估计方法. 本文算法有3个贡献点: 1)将块匹配应用到EPI域中, 根据EPI的线性特点进行光场图像序列的块匹配. 2)在匹配中, 先将图像由RGB颜色空间转到CIELab颜色空间, 计算EPI集中匹配块和待匹配块中的每个像素的对于中心像素的相似性. 3)采用梯度和距离作为平滑项, 计算块中每个像素对于中心像素的权值, 结合CIELab颜色空间的权重值进行综合权重值计算, 之后计算参考图像和各视角图像中块的匹配成本值, 比较不同斜率下的成本值大小, 确定最小成本和对应的最优斜率, 得到最佳的深度图.

1 光场获取及EPI深度估计 1.1 光场获取本文采用相机沿直线运动的方式得到一系列的光场图像, 如图1(a). 由于相机直线运动, 因此这些图像对应的相机光心在同一直线上, 假设为

| ${\Pi _{us}} \times {L_s} \to {R^3},(u,v,s) \to E(u,v,s)$ | (1) |

式中,

图1(a)是获取的光场图像序列, 我们展示了一组光场图像中其中的4张图像. 将得到的光场序列图像按顺序叠加起来, 组成一个三维立体的合集, 如图1(b), 称为EPI集. 其中中间的横向切片表示具有线性特点像素的集合, 即为单个EPI.

图1(b)中, 随着时间的推移, 相机沿着箭头的方向移动, 使目标物点

图1(c)表示由多个目标物点形成的具有线性特点的EPI图.

1.2 光场深度估计对于三维空间中的一点

|

图 1 EPI形成 |

|

图 2 三维空间中一点

|

| ${\textit{z}} = \frac{f}{{\Delta u}} \cdot \Delta s$ | (2) |

式中,

在斜率求解过程中, 受光照和噪声等因素的影响, 单个像素点之间匹配求斜率时误差较大, 本文采用基于自适应权值块匹配的方法来计算斜率.

匹配块是以各视角图像中待匹配像素点为中心像素的

CIELab颜色空间是由CIE(国际照明委员)于1976年制定的一种色彩模式, 它由亮度L(Luminance)和色度信息(a, b)组成. CIELab颜色空间采用坐标Lab, 其中a的正向代表红色, 负向代表绿色, b的正向代表黄色, 负向代表蓝色. CIELab颜色空间对于色彩有较强的感知力, 其中L分量可以密切匹配亮度感知, 因此可以通过修改a和b的分量来感知颜色的相似程度, 由RGB颜色空间转换到CIELab颜色空间的公式如下:

| $X = 0.49 \times R + 0.31 \times G + 0.2 \times B$ | (3) |

| $Y = 0.177 \times R + 0.812 \times G + 0.011 \times B$ | (4) |

| $Z = 0.01 \times G + 0.99 \times B$ | (5) |

由XYZ颜色空间转换转换到Lab颜色空间, 表示如下:

| $ \left\{\begin{array}{*{20}{l}} {L = 116f(Y) - 16}\\ { {{a}} = 500\left( {f\left( {\dfrac{X}{{0.982}}} \right) - f\left( Y \right)} \right) }\\ {{{b}} = 200\left( {f\left( Y \right) - f\left( {\dfrac{Z}{{1.183}}} \right)} \right)} \end{array}\right. $ | (6) |

其中,

在块匹配中, 匹配窗中像素的权值由3个因素决定: 梯度、CIELab颜色空间中颜色差异和距离. 匹配窗中的某一像素离中心像素越近, 颜色差异越小, 梯度差异越小, 则该像素的权值越大. 设参考图像中匹配窗的中心像素为

| $w\left( {{{\vec p}_0},\vec p} \right) = f\left( {\Delta {c_{{{\vec p}_0}\vec p}},\Delta {g_{{{\vec p}_0}\vec p}},\Delta gr{a_{{{\vec p}_0}\vec p}}} \right)$ | (7) |

式中,

| $w\left( {{{\vec p}_0},\vec p} \right) = {f_s}\left( {\Delta {c_{{{\vec p}_0}\vec p}}} \right) \times {f_p}\left( {\Delta {g_{{{\vec p}_0}\vec p}}} \right) \times {f_g}\left( {\Delta gr{a_{{{\vec p}_0}\vec p}}} \right)$ | (8) |

|

图 3 自适应权值算法示意图 |

式中,

| ${f_s}\left( {\Delta {c_{{{\vec p}_0}\vec p}}} \right) = \exp \left( { - \frac{{\Delta {c_{{{\vec p}_0}\vec p}}}}{{{r_s}}}} \right)$ | (9) |

| ${f_p}\left( {\Delta {g_{{{\vec p}_0}\vec p}}} \right) = \exp \left( { - \frac{{\Delta {g_{{{\vec p}_0}\vec p}}}}{{{r_p}}}} \right)$ | (10) |

| ${f_g}\left( {\Delta gr{a_{{{\vec p}_0}\vec p}}} \right) = \exp \left( { - \frac{{\Delta gr{a_{{{\vec p}_0}\vec p}}}}{{{\tau _{gra}}}}} \right)$ | (11) |

式中,

| $\Delta {c_{{{\vec p}_0}\vec p}} = \left\| {{p_0} - } \right.{\left. p \right\|_2} \!=\! \sqrt {{{\left( {{{\vec p}_{{0_L}}} \!-\! {{\vec p}_{_L}}} \right)}^2} \!+\! {{\left( {{{\vec p}_{{0_a}}} \!-\! {{\vec p}_{_a}}} \right)}^2} \!+\! {{\left( {{{\vec p}_{{0_b}}} \!-\! {{\vec p}_{_b}}} \right)}^2}} $ | (12) |

| $ \Delta {g_{{{\vec p}_0}\vec p}} = \left\| {{g_{{{\vec p}_0}}} - } \right.{\left. {{g_{{{\vec p}_{}}}}} \right\|_2} = \sqrt {{{\left( {{x_{{{\vec p}_0}}} - {x_{{{\vec p}_{}}}}} \right)}^2} + {{\left( {{y_{{{\vec p}_0}}} - {y_{{{\vec p}_{}}}}} \right)}^2}} $ | (13) |

| $\Delta gr{a_{{{\vec p}_0}\vec p}} = \Delta gra{x_{{{\vec p}_0}\vec p}} + \Delta gra{y_{{{\vec p}_0}\vec p}}$ | (14) |

其中,

| $\begin{array}{l} \Delta gra{x_{{{\vec p}_0}\vec p}} = \left\| {gra{x_{{{\vec p}_0}}}} \right. - {\left. {gra{x_{\vec p}}} \right\|_2} = \sqrt {{{\left( {gra{x_{{{\vec p}_{}}r}} - gra{x_{{{\vec p}_{}}r}}} \right)}^2} + {{\left( {gra{x_{{{\vec p}_0}g}} - gra{x_{{{\vec p}_{}}g}}} \right)}^2} + {{\left( {gra{x_{{{\vec p}_0}g}} - gra{x_{{{\vec p}_{}}g}}} \right)}^2}} \\ \end{array} $ | (15) |

| $\begin{array}{l} \Delta gra{y_{{{\vec p}_0}\vec p}} = \left\| {gra{y_{{{\vec p}_0}}}} \right. - {\left. {gra{y_{\vec p}}} \right\|_2} = \sqrt {{{\left( {gra{y_{{{\vec p}_{}}r}} - gra{y_{{{\vec p}_{}}r}}} \right)}^2} + {{\left( {gra{y_{{{\vec p}_0}g}} - gra{y_{{{\vec p}_{}}g}}} \right)}^2}{\rm{ + }}{{\left( {gra{y_{{{\vec p}_0}g}} - gra{y_{{{\vec p}_{}}g}}} \right)}^2}} \\ \end{array} $ | (16) |

综上所述,

| $ w\left( {{{\vec p}_0},\vec p} \right) = {\rm{exp}}\left( {{\rm{ - }}\left( {\frac{{\Delta {c_{{{\vec p}_0}\vec p}}}}{{{r_s}}} + \frac{{\Delta {g_{{{\vec p}_0}\vec p}}}}{{{r_p}}} + \frac{{\Delta gr{a_{{{\vec p}_0}\vec p}}}}{{{\tau _{gra}}}}} \right)} \right) $ | (17) |

设像素

| $E\left( {{p_0},{p_{0d}}} \right) = \frac{{{\displaystyle\sum _{p \in {N_{P0}}_{}qd \in {N_{qd0}}}}w\left( {{p_0},p} \right)w\left( {{q_{0d}},{q_d}} \right)e\left( {p,{q_d}} \right)}}{{{\displaystyle\sum _{p \in {N_{P0}}_{}qd \in {N_{qd0}}}}w\left( {{p_0},p} \right)w\left( {{q_{0d}},{q_d}} \right)}}$ | (18) |

式中,

综上所述, 最终的视差值可以通过WTA算法得到:

| ${d_p} = \arg {\min _{d \in D}}E\left( {{p_0},{q_{0d}}} \right)$ | (19) |

其中,

本文算法基于文献[12]提供的数据集和斯坦福数据集进行测试. 为了验证本文算法的性能, 本文结果同时与文献[12, 16]提供的流行深度估计算法进行比较, 从定性和定量两个方面来分析算法的估计结果. 在Windows 7操作系统下, Intel Core(TM)i7-2600 2.6 GHz CPU以及Matlab R2015b的仿真软件下进行验证.

在定量分析中, 采用均方根误差(RMSE)和相对深度误差(B)作为量化指标评价算法性能, 其中RMSE和B值越小, 表示深度估计结果越好.

| $RMSE = \sqrt {\frac{1}{{MN}} \displaystyle\sum \limits_{\left( {x,y} \right)} {{\left( {d\left( {{p_{\left( {x,y} \right)}}} \right) - {d_{GT}}\left( {{p_{\left( {x,y} \right)}}} \right)} \right)}^2}} $ | (20) |

| $B = \frac{1}{{MN}} \displaystyle\sum \limits_{\left( {x,y} \right)} \left( {\left| {d\left( {{p_{\left( {x,y} \right)}}} \right) - \left. {{d_{GT}}\left( {{p_{\left( {x,y} \right)}}} \right)} \right|} \right. > {\delta _d}} \right)$ | (21) |

其中, M, N表示图像的宽和高,

图4展示了文献[12]、文献[16]与本文方法深度估计结果, 可以发现, 本文算法在很好的保留图像边缘信息的同时对于平滑区域也保留了更多的细节信息, 如图4(d)中黑色边框所示, 较好的展示了娃娃脖子区域的细节, 而文献[12]的方法虽然娃娃边缘获得了较好的效果, 但是对于娃娃脖子区域的细节没有展现. 文献[16]方法, 在娃娃边缘上表现的结果较差.

|

图 4 深度估计实验结果图 |

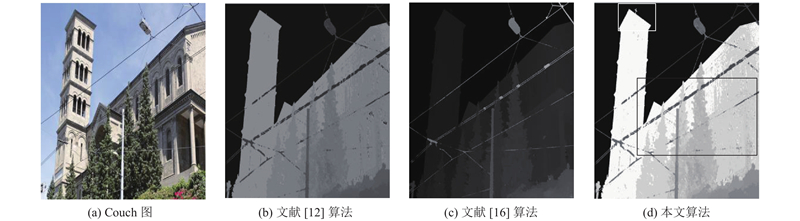

图5是各种深度估计方法求得的深度图, 通过对比可以发现, 本文算法和文献[12]算法一样都可以得到较好的深度图, 但是对于一些微小细节, 如图5(d)中白色边框中的教堂塔尖, 本文算法能够很好的展现. 文本算法在房子和前排植物等平滑区域展现了较好的灰度平缓变化, 即深度的平缓变化过程, 如图5(d)中黑色边框所示, 而文献[16]算法表现的结果较差.

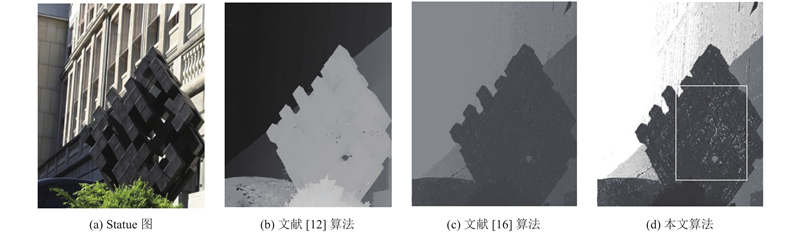

图6中, 本文算法与文献[12, 16]算法均实现了较好的边缘深度估计, 但在平滑区域本文算法较文献[12, 16]算法能够显示更多的细节信息, 如图6(d)中白色边框所示, 通过灰度值的变化显示物体不同深度的变化, 而文献[12, 16]算法表现的结果图较差.

|

图 5 深度估计实验结果图 |

|

图 6 深度估计实验结果图 |

3.2 定量分析

根据给定的数据集深度图真值, 可以进行定量分析. 表1给出了文献[12]、文献[16]以及本文算法的深度估计结果评价指标. 可以看出, 本文方法和文献[12]方法在边缘保存效果明显优于文献[16], 所以均方根误差与相对深度误差值较小. 本文方法在一些微小表现细节方面比文献[12]方法更具有一定的优势, 因此实验数值更小, 与本文中定性评价结果一致.

| 表 1 各方法定量指标 |

另外, 本文算法对于图像平滑区域的细节信息和边缘信息有较好的保持, 获得了较好的深度图. 同时由于本算法支持基于图像中多个匹配块的并行化计算, 算法运行时间大大缩短, 对比文献[12, 16]的方法, 如表2所示, 本文算法的时间复杂度明显降低, 更适合于快速深度估计.

| 表 2 算法运行时间(单位: s) |

4 结论

相比传统的深度估计算法, 本文提出了一种基于CIELab颜色空间的自适应权值块匹配算法. 本算法是在EPI上利用其线性特点进行匹配, 通过线性匹配求得最优斜率并确定最佳深度. 在线性匹配的过程中, 应用基于CIELab颜色空间的自适应权值算法, 求得匹配窗和待匹配窗的权值, 进而通过WTA算法, 确定最优斜率, 并求得深度. 通过对比深度图可以发现, 本文算法不仅能够有效的保留边缘信息, 同时对于内部的平滑区域, 也很好的展现了细节信息. 但对于图中的深度平滑性, 本文算法仍还有所不足. 因此, 在之后的工作中, 我们应该更加关注平滑性, 将深度表现的更加平滑, 得到更完善的深度信息.

| [1] |

Gortler SJ, Grzeszczuk R, Szeliski R, et al. The lumigraph. Proceedings of the 23rd Annual Conference on Computer Graphics and Interactive Techniques. New York, NY, USA. 1996. 43–54.

|

| [2] |

Levoy M, Hanrahan P. Light field rendering. Proceedings of the 23rd Annual Conference on Computer Graphics and Interactive Techniques. New York, NY, USA. 1996. 31–42.

|

| [3] |

Wilburn B, Joshi N, Vaish V, et al. High performance imaging using large camera arrays. ACM Transactions on Graphics (TOG), 2005, 24(3): 765-776. DOI:10.1145/1073204.1073259 |

| [4] |

Davis A, Levoy M, Durand F. Unstructured light fields. Computer Graphics Forum, 2012, 31(2pt1): 305-314. DOI:10.1111/j.1467-8659.2012.03009.x |

| [5] |

Veeraraghavan A, Raskar R, Agrawal A, et al. Dappled photography: Mask enhanced cameras for heterodyned light fields and coded aperture refocusing. ACM Transactions on Graphics, 2007, 26(3): 69. DOI:10.1145/1276377.1276463 |

| [6] |

Zhang YB, Lv HJ, Liu YB, et al. Light-field depth estimation via epipolar plane image analysis and locally linear embedding. IEEE Transactions on Circuits and Systems for Video Technology, 2017, 27(4): 739-747. DOI:10.1109/TCSVT.2016.2555778 |

| [7] |

聂云峰, 相里斌, 周志良. 光场成像技术进展. 中国科学院研究生院学报, 2011, 28(5): 563-572. |

| [8] |

丁伟利, 陈瑜, 马鹏程, 等. 基于阵列图像的自适应光场三维重建算法研究. 仪器仪表学报, 2016, 37(9): 2156-2165. DOI:10.3969/j.issn.0254-3087.2016.09.030 |

| [9] |

郑淼, 赵红颖, 杨鹏, 等. 基于光场数据的无纹理景物视差估计方法. 北京大学学报(自然科学版), 2018, 54(2): 336-340. |

| [10] |

Bolles RC, Baker HH, Marimont DH. Epipolar- plane image analysis: An approach to determining structure from motion. International Journal of Computer Vision, 1987, 1(1): 7-55. DOI:10.1007/BF00128525 |

| [11] |

Criminisi A, Kang SB, Swaminathan R, et al. Extracting layers and analyzing their specular properties using epipolar-plane-image analysis. Computer Vision and Image Understanding, 2005, 97(1): 51-85. DOI:10.1016/j.cviu.2004.06.001 |

| [12] |

Kim C, Zimmer H, Pritch Y, et al. Scene reconstruction from high spatio-angular resolution light fields. ACM Transactions on Graphics, 2013, 32(4): 73. |

| [13] |

丁伟利, 马鹏程, 陆鸣, 等. 基于先验似然的高分辨光场图像深度重建算法研究. 光学学报, 2015, 35(7): 0715002. |

| [14] |

Wanner S, Goldluecke B. Variational light field analysis for disparity estimation and super-resolution. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(3): 606-619. DOI:10.1109/TPAMI.2013.147 |

| [15] |

Wanner S, Goldluecke B. Globally consistent depth labeling of 4D light fields. Proceedings of 2012 Computer Vision and Pattern Recognition. Providence, RI, USA. 2012. 41–48.

|

| [16] |

Wanner S, Goldluecke B. Spatial and angular variational super-resolution of 4D light fields. Proceedings of the 12th European Conference on Computer Vision-ECCV 2012. Florence, Italy. 2012. 608–621.

|

| [17] |

Tao MW, Hadap S, Malik J, et al. Depth from combining defocus and correspondence using light-field cameras. Proceedings of 2013 IEEE International Conference on Computer Vision (ICCV). Sydney, NSW, Australia. 2013. 673–680.

|

2020, Vol. 29

2020, Vol. 29