2. 上海中医药大学 上海中医健康服务协同创新中心, 上海 201203

2. Shanghai Innovation Center of TCM Health Service, Shanghai University of Traditional Chinese Medicine, Shanghai 201203, China

由于计算机硬件性能的提高, 深度学习及其应用成为目前研究的热点, 包括图像、语音等的识别. 脉诊是传统中医的重要组成部分, 客观化研究尚未成熟, 不同经验积累的医生对于疑难病症有不同的诊断结果. 深度学习用于处理医学图像、脉搏波、心电图等, 有助于提升识别准确率, 将推动智慧医疗的发展.

深度神经网络(Deep Neural Networks, DNN)包括卷积神经网络(Convolutional Neural Networks, CNN)、递归神经网络(Recurrent Neural Networks, RNN)和强化学习(Reinforcement Learning, RL). CNN在图像识别领域应用广泛, LeCun[1]等提出LeNet, 包括卷积层、池化层、Sigmoid激活函数, 多层感知机是最后的分类器, 奠定了CNN的基本组成. Krizhevsky[2]等提出AlexNet, 使用线性修正单元(Rectified Linear Unit, ReLU)作为激活函数, 解决了网络加深时的梯度弥散问题; 使用Dropout随机忽略部分神经元, 避免过拟合; 使用重叠的最大池化和CUDA加速. Simonyan等[3]研究了CNN深度与性能的关系, 提出VGGNet, 反复堆叠3×3的卷积核和2×2的最大化池化层, 构建了16~19层深的CNN, 初步证明网络越深, 效果越好; Szegedy等[4]提出Google Inception Net (GoogLeNet), 是一种模块化的高效稀疏结构, 参数量和运算量比之前的神经网络少, 跨通道提取特征, 有利于提取多样性特征. He等[5]提出残差神经网络(Residual Neural Networks, ResNet), 网络深度可达上百层, 解决了网络加深时性能先升后降的退化问题, 使某些重要特征可直接传输到任一模块或层. 这些经典网络是CNN发展的里程碑.

Liu等[6]提出基于GoogLeNet的时序自适应神经网络, 由于Inception模块中多尺度的卷积核, 可用于识别视频帧之间的相关性动作, 运行时间较少且鲁棒性强, 表明Inception模块能较好地处理时序型数据; Khosravi [7]等提出改进的Google Inception-V3, 用于识别肺癌、膀胱癌、乳腺癌的病理图, 准确率分别达到100%、92%、95%, 对肿瘤异质性病理图的分类性能很好, 能有效识别多种特征; Vesal等[8]在ImageNet 数据集上预训练Google Inception V3 模型, 识别特定领域的特征, 然后, 利用迁移学习, 用预训练好的Google Inception V3模型识别乳腺癌病理图, 测试准确率达到97.08%, 结合医学专家的分析, 尝试应用于临床. GoogLeNet主要有以下优势: (1) 由不同的卷积层和一个池化层组成的Inception模块, 构建了一种高效的稀疏结构, 有利于提取丰富的纹理特征; (2) 常用多种大小的卷积核, 比如1×1、3×3、5×5、7×7等, 提取不同层次的高阶特征, 增加特征提取的多样性; (3) 模块中有不同的分支网络, 增加了网络宽度, 提高了网络的鲁棒性和表达能力, 使其对不同分辨率的图像有更好的泛化能力.

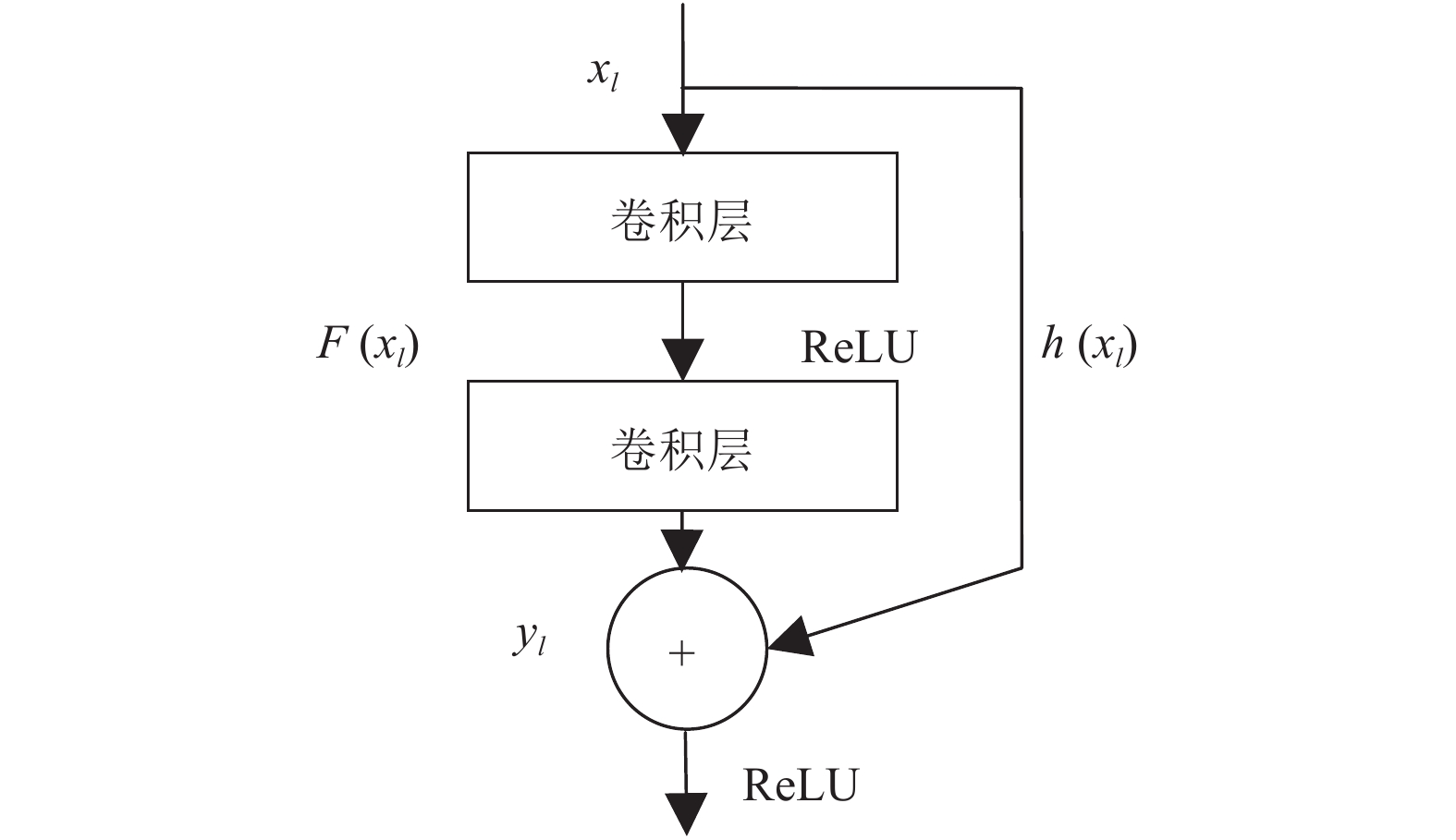

随着网络层数增加, CNN的性能逐渐提升, 当达到一定层数时, 梯度发散问题会导致性能下降. ResNet采用残差模块(Residual Modules)或跳跃连接(Skip Connection)解决了此问题(如图1), 使网络层数更多, 简化了网络的学习目标, 不同单元及层的信号可直接正向和反向传输给任一层, 加速网络训练和参数调优. Zhang等[9]提出将中心损失函数用于ResNet, 在手写体汉字集ICDAR-2013上取得97.03%的准确率; Lu等[10]提出深度耦合ResNet, 由一个主干网络和两个分支网络组成, 主干网络用于识别不同分别率的人脸照片, 两个分支网络分别训练高分辨率图片和目标图片, 将其转化成特定分辨率的耦合图片.

|

图 1 残差模块 |

| $F({x_l}) = w * {x_l} + b$ | (1) |

| ${y_l} = R(F){\rm{ + }}h({x_l})$ | (2) |

| ${x_{l + 1}} = R({y_l})$ | (3) |

式中,

| $R(x) = \max (0,x)$ | (4) |

当

研究者也探索了整合两种网络优势, 以构造融合网络. Habibzadeh等[11]提出预训练的Inception-ResNet, 用于四种主要白细胞的分类, Inception-V1-ResNet获得99.84%的准确率; Szegedy等[12]在Inception结构中加入残差模块, 发现残差模块可以加速Inception网络训练, 但不能明显提高准确率; Zhuang等[13]将Google Inception V3和不同的长短期记忆网络(Long Short Term Memory, LSTM)融合, 构造ConvDLSTM, 在人群图片集上统一训练模型, 将时间和空间信息统一在一个神经网络结构中, 有效检测人群信息. 网络结构的融合, 不是简单的组合, 而需要改进网络结构和参数设置等.

基于DNN的脉搏波识别, 研究较少. Hu等[14]用基本的CNN(9L)识别健康和亚健康的脉搏波信号, 准确率达到72.31%; Zhang等[15]用9层的CNN识别弱脉、弦脉、深脉等12种脉搏, 平均准确率达到93.49%; Zhou等[16]组合DNN和规则推理, 在心电图数据集MIT-BIH-AR上检测室性早搏, 准确率、特异性和灵敏度分别达到99.41%、99.54%和97.59%. Jin等[17]搭建由医生监控的云计算平台, 该平台嵌入深度学习、规则推理和集成学习等, 辅助诊断心脏疾病, 输入病人的12导联ECG数据并给出诊断报告. 有关脉搏波识别存在以下问题: (1) 基于深度学习的脉搏波识别研究较少, 只使用一些基本的神经网络, 而性能更好的ResNet、深度融合神经网络、生成对抗网络(Generative Adversarial Networks, GAN)等并未使用; (2) DNN用于脉搏波识别, 需要调整网络结构、卷积核大小和数量、学习策略、损失函数等, 将影响识别的准确率; (3) 目前已有的脉搏波识别算法, 其准确率较低, 难以达到临床应用的要求; (4) 脉搏波数据集缺乏标准, 研究者使用不同的数据集, 难以评测算法的性能.

本文提出由改进的Inception 模块、残差模块和池化模块组成的深度融合神经网络Modified Inception-ResNet (MIRNet), 包括MIRNet1和MIRNet2, 其中MIRNet2的准确率达到87.84%, 性能最优, 分析了MIRNet2的结构和原理. 本文首先介绍数据集预处理的方法; 其次, 分析Inception模块和残差模块融合的原因, 构建IRNet和MIRNet融合网络, 探究融合网络的原理; 此外, 介绍参数量和运算量、准确率等网络性能评测指标. 随后, 介绍实验和分析结果, 最后是结论与展望.

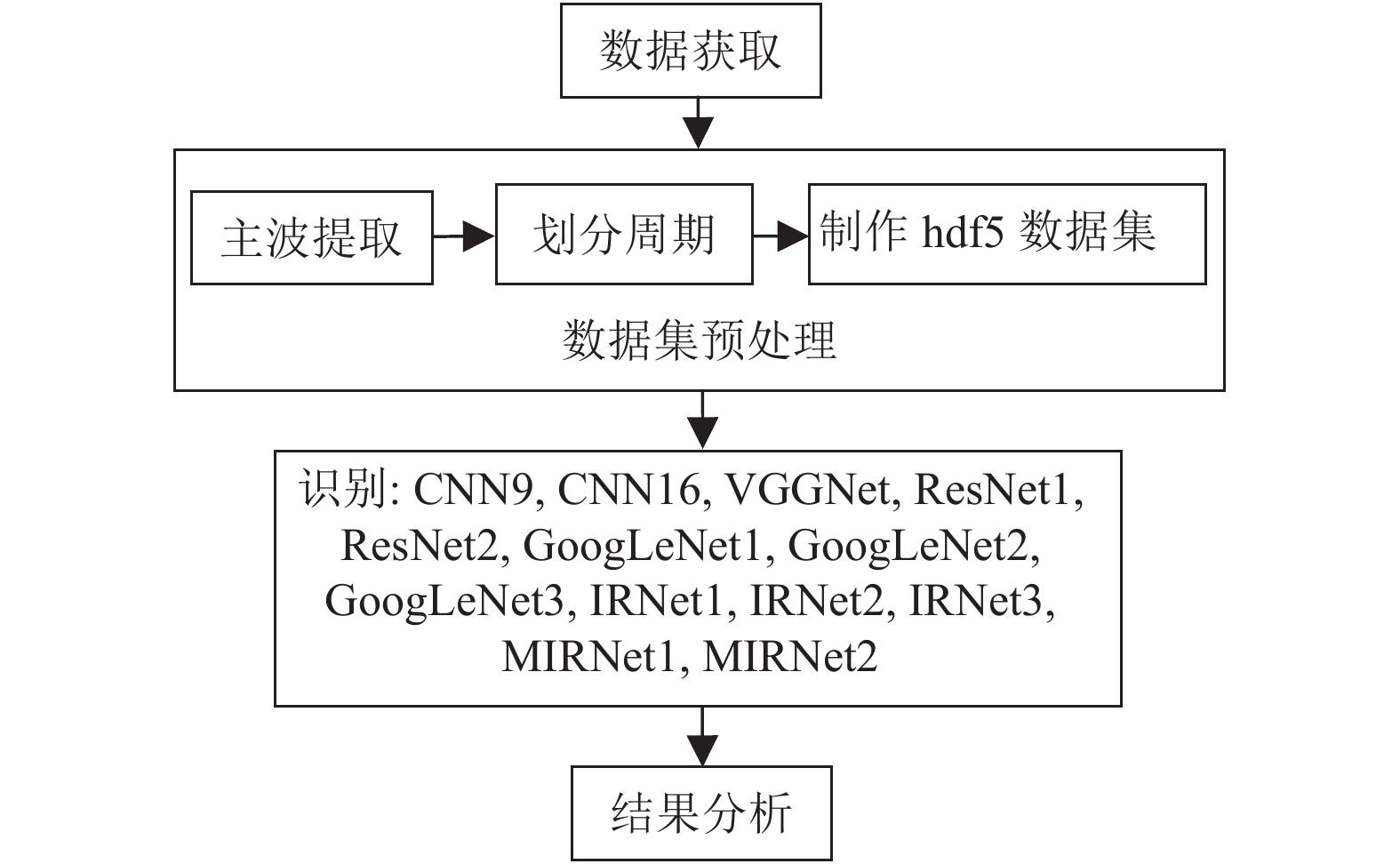

2 方法主要阐述数据集预处理、IRNet及MIRNet的结构、参数量、运算量计算及准确率等评价指标. 实验流程, 如图2所示, 主要分为数据集预处理、算法识别和结果分析.

|

图 2 脉搏波识别流程 |

2.1 数据集获取和预处理 2.1.1 数据集获取

数据来源为上海中医药大学研发的DDMX-100脉象仪采集的1125个健康对象和1158个亚健康对象的脉搏波, 采样频率为200 Hz, 持续40 s, 共计8000个采样点. 根据世界卫生组织公布的区分健康和亚健康的20项指标, 以调查问卷形式询问被调查者, 得分大于80分者为健康对象, 反之为亚健康对象[14].

2.1.2 主波提取基于香农能量和希尔伯特变换的脉搏波主波提取算法过程: 脉搏波原始信号首先经过带通滤波去除高频噪声(工频噪声)和低频噪声(基线漂移); 然后, 进行幅值归一化; 归一化后的脉搏波再进行香农能量变换, 经过低通平滑滤波得到香农能量包络线; 包络线在希尔伯特变换之后减去均值, 滤除信号因突变产生的干扰, 在此基础上, 找出香农能量包络线的峰值点. 对比和分析大量的香农能量包络线峰值点和只经过带通滤波的脉搏波峰值点, 发现二者的出现时间相差0~0.25秒. 因此, 香农能量包络线的峰值点的位置前后约0.25秒的范围对应着脉搏波主波位置所在的时间范围. 在此范围内, 可以找到脉搏波真正的主波位置[14].

2.1.3 划分周期为了保证每个分段至少包含一个完整的脉搏波周期, 其周期是1.25秒, 因此选择250个点作为一个周期, 以主波位置为基准, 向前取99个点, 向后取150个点, 即可作为一个周期, 如图3所示[14]. 每条数据增加一列标签, 0和1分别代表健康和亚健康. 共计118 800条1×250周期, 加标签0或1后, 变为1×251, 随机选择60%的数据为训练集, 即71 280条, 40%为测试集, 也是评价集, 即47 520条.

|

图 3 脉搏波信号 |

由图3可知, (1) 脉搏波信号是典型的时间序列数据, 前后文相关性很大. (2) 升支、主波、重波前波、降中峡等是脉搏波具有生理意义的重要特征, 是脉诊的主要依据, 比如升支反映了心室收缩、快速射血、主动脉血量增加, 此时动脉血压升高, 出现陡峭而平滑的脉搏波曲线, 继而出现主波, 主波峰值点对应收缩压, 即收缩期的最高血压[14]. 但它们在各自周期内的波幅、出现时间(或出现位置点)等均不同. (3) 存在噪声, 比如在每个周期将结束时, 有轻微波动. 因此, 需要针对脉搏波数据的自身特征, 构建合适的网络结构.

2.1.4 制作hdf5数据集Caffe作为深度学习的平台, 处理脉搏波数据时, 需将数据集转化成Caffe可读的hdf5格式的数据集.

2.2 IRNet及MIRNet的结构和原理 2.2.1 网络融合的原因GoogLeNet中的Inception模块及其变种存在缺点: (1) 基本的Inception模块, 对网络性能提升的作用有限, 其变种则过于复杂, 参数量和运算量成为负担, 过拟合现象频发; (2) 网络宽度较宽, 深度不足, 宽度与深度失衡, 参数运算效率低. ResNet中的残差模块亦有不足: (1) 虽然加深了网络, 提升了网络的分类准确率, 但参数量和运算量却快速增长, 比Inception模块及其变种增长快; (2) 网络结构加深, 但宽度较窄, 深度与宽度失衡, 特征提取的多样性比Inception模块差; (3) 如果残差模块过于复杂, 则跳跃连接带来的训练加速作用弱于参数量和运算量急剧增加带来的训练减速作用, 易导致训练中断或梯度爆炸. 在一定程度上, Inception模块和残差模块可以优势互补.

此外, 根据脉搏波的特点: (1) 残差模块中的跳跃连接, 可认为是没有门机制的LSTM, 门机制允许一部分数据经过简单特征提取后直接进入下一层; 然而, LSTM结构不能加深, 单个模块的性能优于简单的CNN, 但其性能低于适当加深的ResNet和GoogLeNet. 跳跃连接基本适合于脉搏波的第一个特点. (2) Inception模块各分支的特征提取, 能获得多样的特征, 此基本适合于脉搏波的第二个特征.

鉴于以上初步分析, 提出由Inception模块和残差模块组成的融合网络Inception-ResNet (IRNet).

另外, 研究了CNN9、CNN16、VGGNet、ResNet及GoogLeNet等网络用于脉搏波识别. CNN9和CNN16, 包含卷积层、池化层、全连接层及Dropout层, 共计9层和16层, 每个卷积层都有BatchNorm、Scale、ReLU等. VGGNet中池化层数量少于CNN16, 但总层数相近. ResNet1 和ResNet2使用不同的残差模块, 卷积核大小和数量也不同, ResNet1由残差模块res2(a, b)、res3(a, b)、res4(a, b)和res5(a, b)组成; ResNet2由残差模块res2(a, b, c)、res3(a, b, c, d)和res4(a, b, c, d, e)组成. GoogLeNet1、GoogLeNet2和GoogLeNet3分别由1、2、3个Inception模块组成.

2.2.2 IRNet结构IRNet是由基本的Inception模块和残差模块构成, 包括三个网络, 依次命名为IRNet1、IRNet2和IRNet3, 主要思路是构建Inception模块和残差模块融合的神经网络, 经过实验, 调整各模块的排列顺序、连接方式和模块中的组成单元, 比如模块中的卷积层数量、池化层数量、卷积核大小、通道数量等. 三个融合网络的共同点是: (1) 网络中, 很多卷积层都包括BatchNorm(BN)、ReLU(R)和Scale(S). BN是一种有效的正则化方法, 加速大规模神经网络的训练, 一般和Scale同时使用[18]; (2) 网络的起始部分, 都用卷积核较大的卷积层, 降低参数量和运算量, 网络中的全连接层, 都用到Dropout层, 避免过拟合.

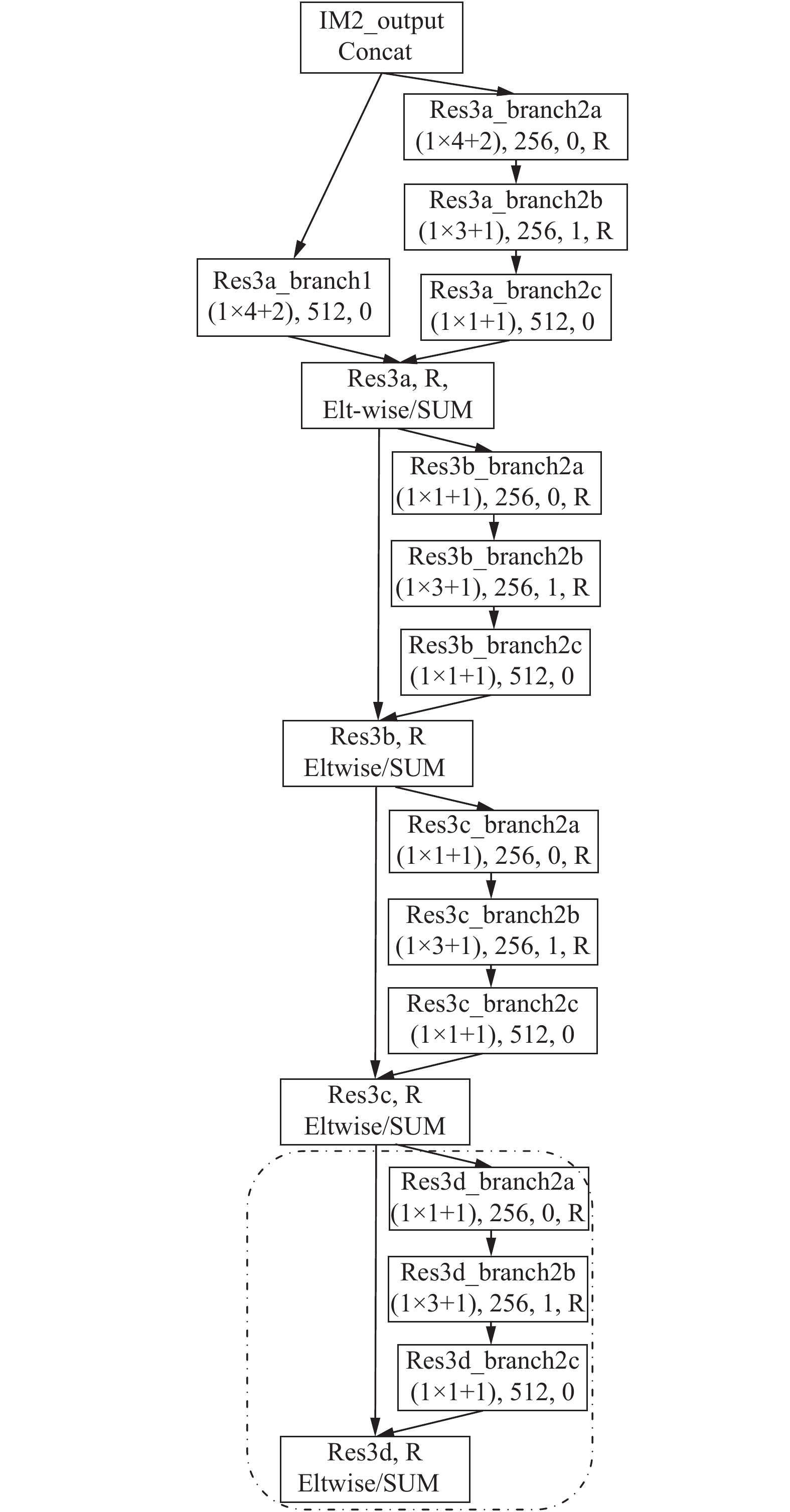

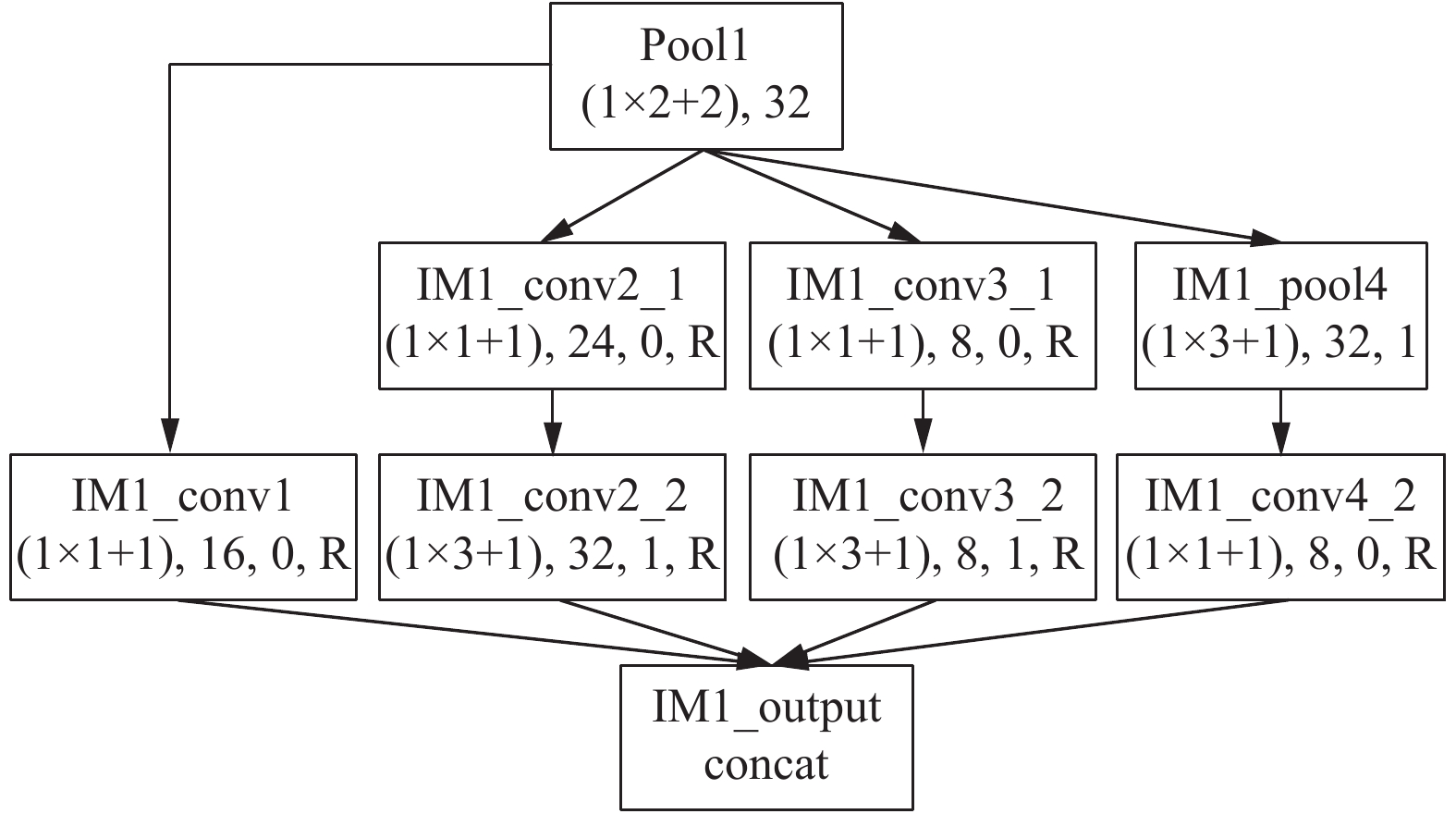

在实验中, 当两个Inception模块直接相连时, 网络的分类性能会下降; 当三个Inception模块直接相连时, 训练时会发生梯度爆炸. 如果残差模块过于复杂, 也会发生梯度爆炸. IRNet1由一个Inception模块(first Inception Module, IM1)和一个残差模块[res3(a, b, c, d)]构成; IRNet2由两个Inception模块(IM1和Second Inception Module, IM2)和一个残差模块[res3(a, b, c, d)]构成; IRNet3由两个Inception模块(IM1和IM2)和两个残差模块[res3(a, b, c, d)和res4(a, b, c)]构成. 当第二个残差模块为res4(a, b, c, d, e)时, IRNet3训练发生中断; 当继续增加Inception模块和残差模块数量, 网络的分类性能会反而下降. 残差模块res3(a, b, c, d)如图4所示, IM2_output、res3a等表示层或模块的名称, (1×4+2)表示卷积核是1×4和步长是2, 256、512等表示输出通道数, 1和0表示填充零和不填充零, R表示ReLU层, Eltwise/SUM表示特征拼接方式. IM1如图5所示, pool1、IM1_output、IM1_conv3_1等表示该层名称, 8、16、32等表示通道数, Concat表示另一种特征拼接方式. Eltwise/SUM是在分辨率层面拼接, 输入维度(batch_size, channel, w, h)必须相同, 增加算法耗时; Concat在通道数(channel)层面拼接, 计算相对简单.

|

图 4 res3(a, b, c, d)的结构图. res4(a, b, c)和res3的结构相似, 但res4不含在虚线框中的”res3d”, 即, 没有res4d |

|

图 5 IM1, 和IM2结构相似, 区别在于卷积核大小和个数不同 |

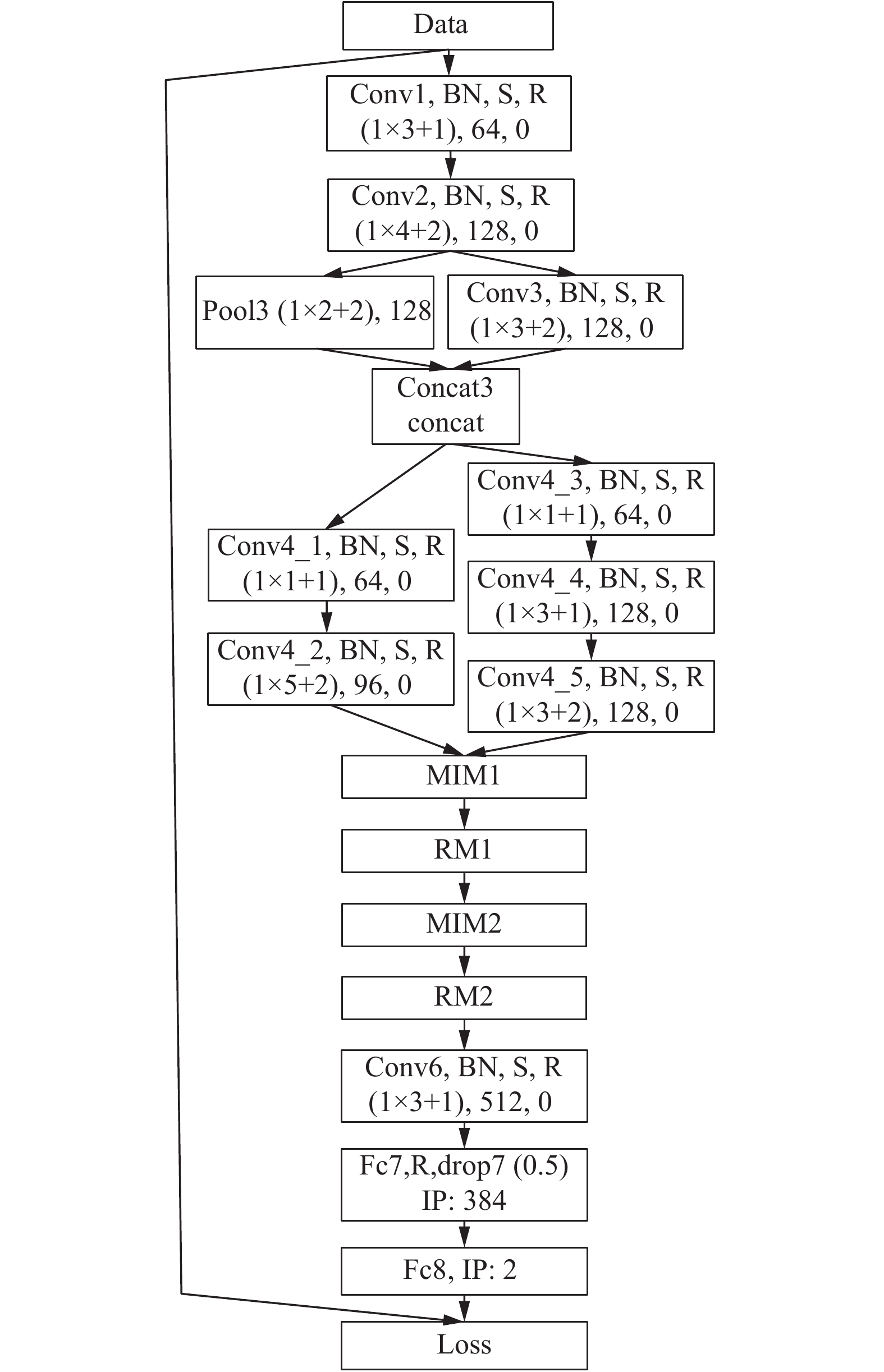

在IRNet中, IRNet3有更好的分类性能, 网络结构如图6, BN和S表示BatchNorm层和Scale层, fc7和fc8表示全连接层(fully-connected layer), drop表示Dropout层, 随机丢弃50%的连接, IP表示全连接层的通道数, loss表示SoftmaxWithLoss 层.

|

图 6 IRNet3的结构图 |

2.2.3 MIRNet的结构和原理 2.2.3.1 MIRNet结构

在实验中, IRNet3的识别准确率与ResNet2相近, 但是ResNet2的参数量和运算量更大, 其残差模块res2(a, b, c)、res3(a, b, c, d)和res4(a, b, c, d, e)是参数量和运算量急剧增长的主要因素. 在IRNet3基础上, 提出由改进的Inception模块、残差模块和池化模块组成的融合网络MIRNet, 主要思路是: (1) 根据脉搏波第一特点, 残差模块的跳跃连接不可缺少, 但是要降低模块复杂度, 特征拼接方式由Eltwise/SUM改为Concat, 弱化其带来的参数量和运算量增加等负作用. (2) 根据脉搏波的第二特点, Inception模块应更丰富, 增加模块中的分支, 使用较小的卷积核, 但是要保持高效的稀疏结构. 特征拼接方式为Concat, 增加更多的特征表示, 保持相对较小的运算量. 这些改进有助于提取不同阶的抽象特征, 增强模块的表达能力. (3) 根据脉搏波第三特点, 在改进模块的分支网络中, 最后一层是ReLU, 可以认为是加入特征提取权重, 随着网络的训练而自动调节各分支网络提取的特征; (4) 取消单独使用的池化层, 改为池化模块, 源于(2)的分析, 但和改进Inception模块不同的是, 其减小了特征面, 起到池化层的作用.

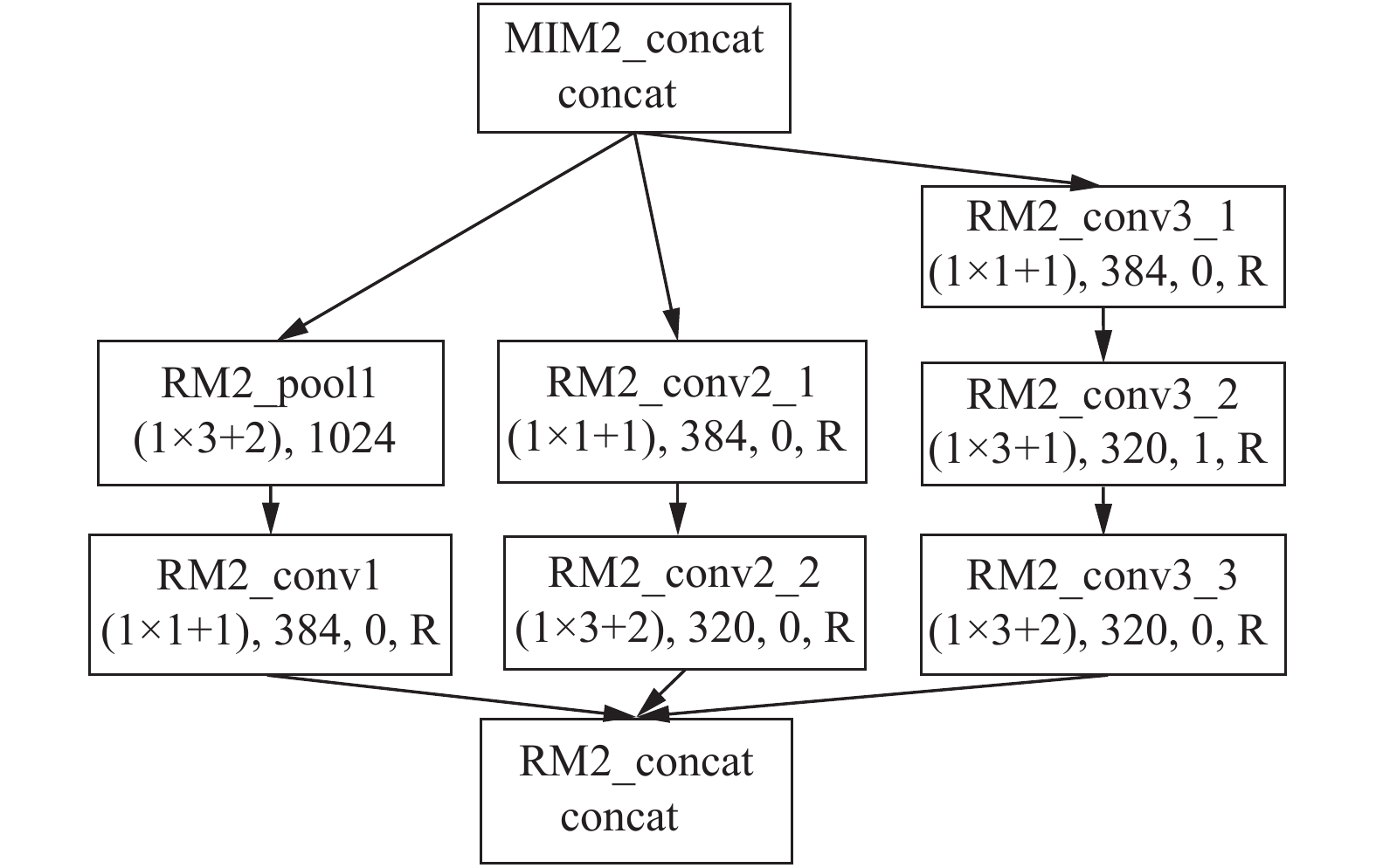

MIRNet主要有两个改进网络, MIRNet1和MIRNet2, MIRNet1主要作用是研究改进模块组成融合网络的可行性, MIRNet2是主要改进的融合网络. 改进模块: (1) 利用残差模块的原理, 构造pool3/conv3, 使池化层pool3和卷积层conv3并列为网络的两个分支; 构造conv4_1~conv4_5等模块, 精简原有的残差模块, 拼接方式改为Concat, 主要是减少参数量和运算量. (2) 在改进的Inception模块(Modified Inception Modules, MIM1和MIM2)中, 使用1×1、1×2、1×3等较小卷积核, 有利于提取更精细的特征. 1×1卷积核改变层间连接数量, 对输出通道升维或降维, 增加特征的非线性变换, 提高网络的泛化能力, 有侧重地保留不同层次的高阶特征[19]; (3) 池化模块(Reduction Modules, RM), 改变以往使用单一池化层的方式, 包含三个分支, 一支是池化层, 另外两支是卷积层, 使特征面分别池化和卷积, 减小特征面, 保证提取特征的多样性. MIRNet1由MIM1和RM1组成, MIRNet2在MIRNet1可行的基础上增加MIM2和RM2. MIM2和RM2分别如图7和图8所示, RM1_concat、RM2_pool1、MIM2_conv3_3等表示该层的名称, 连接方式为Concat. 图9是性能更优的MIRNet2的结构.

2.2.3.2 MIRNet的原理根据MIRNet的构造思路和网络结构, 模块是网络的主要组成, 均可抽象成由不同的特征提取过程组成的特征提取模块.

|

图 7 MIM2, 与MIM1相比, 有两个分MIM2_conv3_2和MIM2_conv3_3, 而MIM1只有一个分支MIM1_conv3_2, 二者的卷积核大小和数量不同. |

|

图 8 RM2, 与RM2相比, RM1在池化层RM2_pool1下面没有RM2_conv1, RM2_conv1的作用是减少层间连接数, 且二者卷积核大小和数量不同. |

由式(1)、(2)、(3) 可得, 在特征拼接时, 去掉ReLU函数, 即

| ${x_{l + 1}} = {y_l}$ | (5) |

| $\begin{split} {x_L} = &\left[ {{R_{11}}({w_{11}}{x_l} + {b_{11}}) + {R_{12}}({w_{12}}{R_{11}} + {b_{12}})} \right] \\ &{\rm{ + }} \left[ {{R_{21}}({w_{21}}{x_l} + {b_{21}}) + {R_{22}}({w_{22}}{R_{21}} + {b_{22}})} \right] \\ \end{split} $ | (6) |

假设, 某模块有

| ${x_L}{\rm{ = }}\sum\limits_{i = 1}^n {\left[ {{R_{i1}}({w_{i1}}{x_l} + {b_{i1}}) + \sum\limits_{j = 2}^m {{R_{ij}}({w_{ij}}{R_{ij - 1}} + {b_{ij}})} } \right]} $ | (7) |

反向传播时, 损失函数

| $\frac{{\partial S}}{{\partial {x_l}}} = \frac{{\partial S}}{{\partial {x_L}}}\frac{{\partial {x_L}}}{{\partial {x_l}}}{\rm{ = }}\frac{{\partial S}}{{\partial {x_L}}}\sum\limits_{i = 1}^n {\left( {r{w_{i1}} + {r^2}{w_{i1}}{w_{i2}} + \cdots + {r^m}\prod\limits_{j = 1}^m {{w_{ij}}} } \right)} $ | (8) |

由式(8)得:

| $\frac{{\partial S}}{{\partial {x_l}}} = \frac{{\partial S}}{{\partial {x_L}}}\sum\limits_{i = 1}^n {\left[ {\sum\limits_{j = 1}^m {\left( {{r^j}\prod\limits_{j = 1}^m {{w_{ij}}} } \right)} } \right]} $ | (9) |

式中,

|

图 9 MIRNet2的结构图 |

MIRNet2模块的分支数量多为2、3、5个, 比如pool3/conv3、conv4_1~conv4_5、RM2和MIM2等, 分支中的单元含1、2、3个卷积和ReLU等操作, 模块深度适当. 训练过程中, ReLU自动调节梯度衰减, 当遇到脉搏波次要特征和噪声时, 导数为0, 梯度不变, 损失函数未减小, 继续寻找使损失函数减小的梯度下降路径; 当遇到重要特征, 导数为1, 梯度减小, 损失函数减小, 准确率增大, 学习到重要特征. 弱化噪声和次要特征, 使分支网络提取到重要特征. 各改进模块对特征进行不同程度地变换, 提取不同层次的高阶特征和前后文的相关性特征, 保持较低的参数量和运算量. 但是, 模块中的分支也不应过多, 网络宽度和深度应平衡.

2.3 参数量和运算量计算网络中, 池化层、BN、ReLU、Concat等参数量和运算量很小, 相对于卷积层, 可忽略不计. 某卷积层的参数量P:

| $P = C * \left( {{K_1} * {K_2}{\rm{ + }}1} \right)$ | (10) |

某卷积层的运算量

| $OP = {C_1}*{C_2}*W*H*\left( {{K_1}*{K_2} + 1} \right)$ | (11) |

式中,

由式(10)和式(11)可知, 参数量取决于通道数量和卷积核大小; 运算量取决于上下层的通道数量、卷积核大小和特征面大小.

2.4 性能评价CNN的分类性能通过准确率(Accuracy, ACC)、特异性(Specificity, SP)、灵敏度(Sensitivity, SE)和约登指数(Youden’s index, γ)等评价. ACC表示算法识别的准确率, 是算法分类性能的综合指标; SP表示算法检测出阴性样本(健康)的能力; SE表示算法检测出阳性样本(亚健康)的能力;

真阳性(True Positive, TP): 算法检测正确的阳性样本数量;

真阴性(True Negative, TN): 算法检测正确的阴性样本数量;

假阳性(False Positive, FP): 算法检测错误的阳性样本数量;

假阴性(False Negative, FN): 算法检测错误的阴性样本数量.

| $SE = \frac{{TP}}{{TP + FN}}$ | (12) |

| $SP = \frac{{TN}}{{TN + FP}}$ | (13) |

| $ACC = \frac{{TP + TN}}{{TP + TN + FN + FP}}$ | (14) |

| $\gamma = SE + SP - 1$ | (15) |

本节介绍了实验环境、网络参数和训练参数, 重点阐述实验结果与分析等.

3.1 实验环境和参数设置 3.1.1 实验环境实验环境如表1所示.

| 表 1 实验环境 |

3.1.2 参数设置

网络参数: (1) 使用较小的卷积核, kernel_h为1, kernel_w为1、3、5等, 步长stride_h为1, stride_w为1或2. 随着卷积层数的增加, 通道数和层间连接数也会增加. 全连接层, 一般不应超过1024个连接节点, 否则会梯度爆炸. (2) 网络中的卷积层: convolution_param的weight和bias初始化为“msra”和“false”. BatchNorm层中, batch_norm_param {use_global_stats:false}; Scale层中, scale_param{bias_term:false}, 初始化为false, 方可在训练中不断优化batch_norm_param和scale_param的值, 初始化为True, 则不会优化. 全连接层inner_product_param中weight_filler和bias_filler分别初始化为“Xavier”和“constant”.

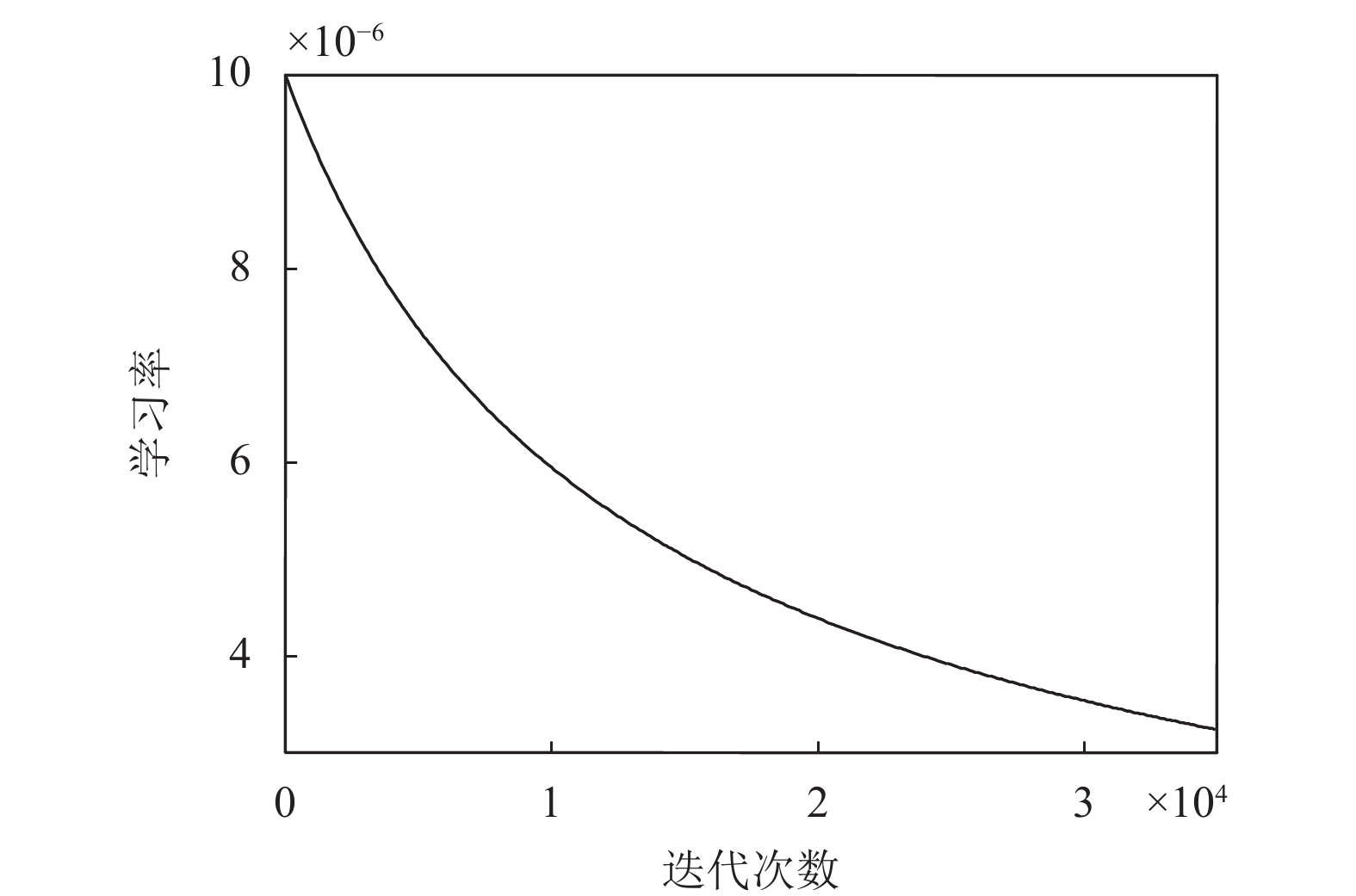

训练参数: batch_size设为10, test_iter设为500, test_interval设为400, 称为一代(epoch), Max_iter设为35 000, 完成对测试集所有数据8~9次的测试, 共87代. 经实验分析, 学习策略lr_policy设为“inv”,

| $lr = base\_lr * {(1 + gamma * iter)^{( - power)}}$ | (16) |

式(16)中,

| $lr = {\left[ {{{10}^5}*{{(1 + {{10}^{ - 3}}iter)}^{0.75}}} \right]^{ - 1}}$ | (17) |

学习率与迭代次数的图像如图10.

|

图 10 学习率与迭代次数曲线 |

由图10可知,

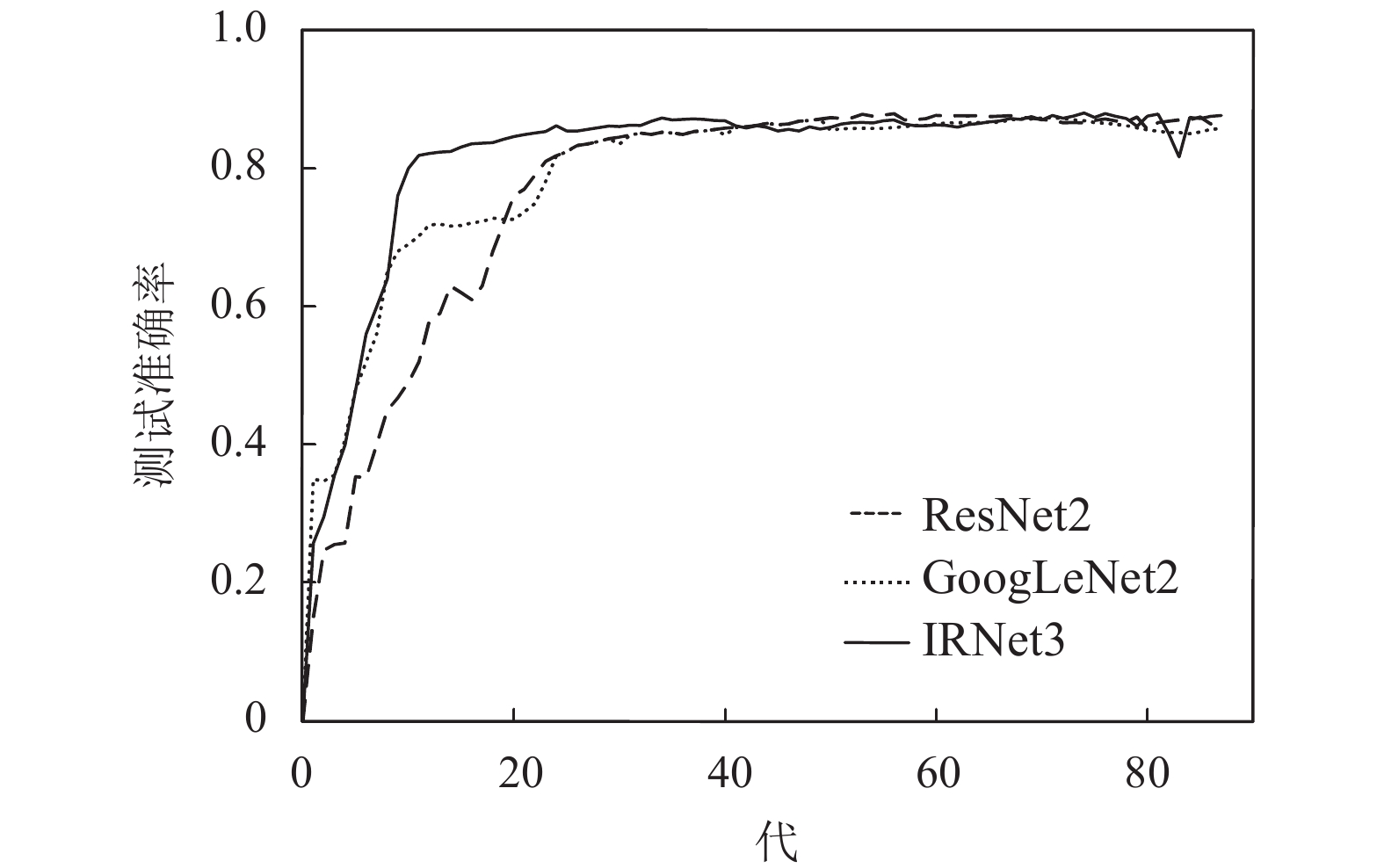

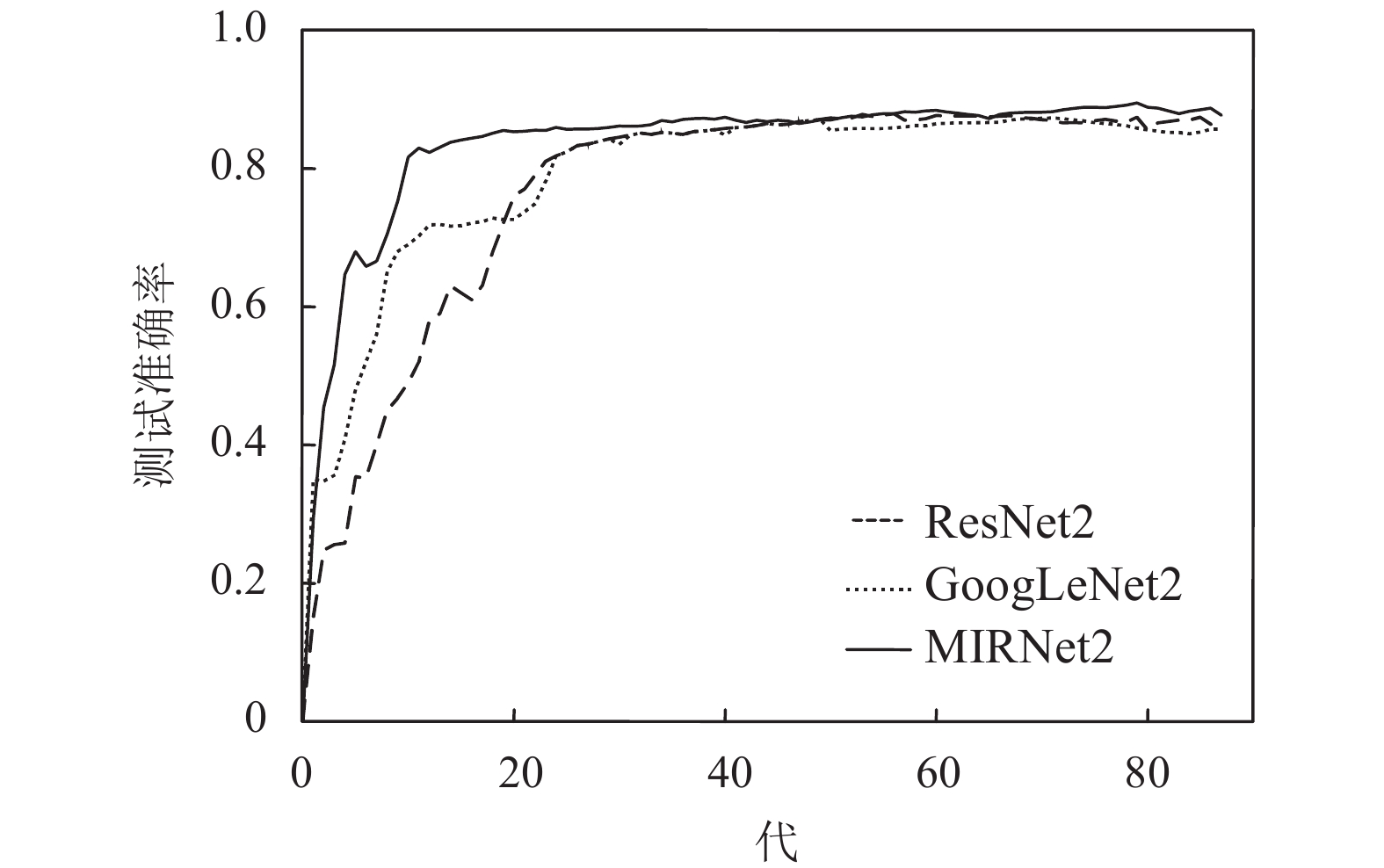

经过实验, 各网络测试结果如表2所示, 选取相似网络中性能较好的CNN9、CNN16、ResNet2、GoogLeNet2、IRNet3、MIRNet2等, 绘制其训练过程中的测试准确率曲线, 如图11、图12和图13所示.

CNN9: CNN(9L)是Hu提出的网络模型, 用于脉搏波识别, 但是其只使用了基本的卷积层、池化层和全连接层. CNN9相比于CNN(9L), 每个卷积层中, 包含BatchNorm、Scale和ReLU, 并在全连接层中含有Dropout层, 准确率提升了10.8%. 其中, BatchNorm和Scale的主要作用是加速网络训练, Dropout 的主要作用是避免过拟合, ReLU有助于提升准确率. 在训练过程中, ReLU通过调节梯度衰减, 突出脉搏波重要特征、次要特征和噪声之间的差别, 增强重要特征在分类中的影响, 弱化次要特征和噪声, 提高了脉搏波识别的准确率. 在此过程中, 未损害重要特征的完整性, 只是增加对重要特征的高阶变换, 使其在高维空间线性可分.

| 表 2 各网络的分类性能 |

|

图 11 CNN9、CNN16、IRNet3和MIRNet2测试准确率曲线 |

|

图 12 ResNet2、GoogLeNet2和IRNet3测试准确率曲线 |

CNN16和VGGNet: 相比于CNN9, CNN16结构更深, 准确率提高了1.83%, 而VGGNet仅提升了0.2%. CNN16比VGGNet的准确率高出1.63%, γ高出7.9%, 避免失败的能力提高. 图11所示, 训练过程中, CNN9比CNN16更快达到稳定, 加深网络使训练速度减小, 但对网络分类性能的提升作用明显. CNN16有更多的通道数、更小的卷积核, 网络结构和参数设置也优于VGGNet.

|

图 13 ResNet2、GoogLeNet2和MIRNet2测试准确率曲线 |

ResNet: 相比于CNN16, ResNet1由4个简单的残差模块组成, 网络层数更深, 准确率高出0.59%, γ高出0.84%. 相比于ResNet1, ResNet2由3个复杂的残差模块组成, 跳跃连接的作用更明显, 加深网络, 并未使网络臃肿, 准确率高出1.44%, γ高出3.81%, 算法避免失败的能力更高, 对阴性样本和阳性样本的测试性能更好. 但是, 在实验中, 继续增加残差模块, 使网络更深, 则导致网络训练中断.

GoogLeNet: 3个改进网络, 分别是GoogLeNet1、GoogLeNet2和GoogLeNet3, 依次使用了1、2、3个Inception模块. 表2中, GoogLeNet1和GoogLeNet3的准确率都低于CNN16, 仅GoogLeNet2的准确率高于CNN16, 对比图11和图12, GoogLeNet2准确率达到稳定的时间快于CNN16, 表明在网络深度接近时, 加宽能改善网络性能. 由表2和图12可知, ResNet1和ResNet2的准确率都高于GoogLeNet2, 尤其是ResNet2比GoogLeNet2高出1.52%, 但其准确率达到稳定状态的速度慢于GoogLeNet2. ResNet2的网络结构更深, 残差模块的作用更明显, 加深比加宽对网络性能的提升作用更明显. 当两个以上的Inception模块直接相连时, 对脉搏波的分类准确率反而下降.

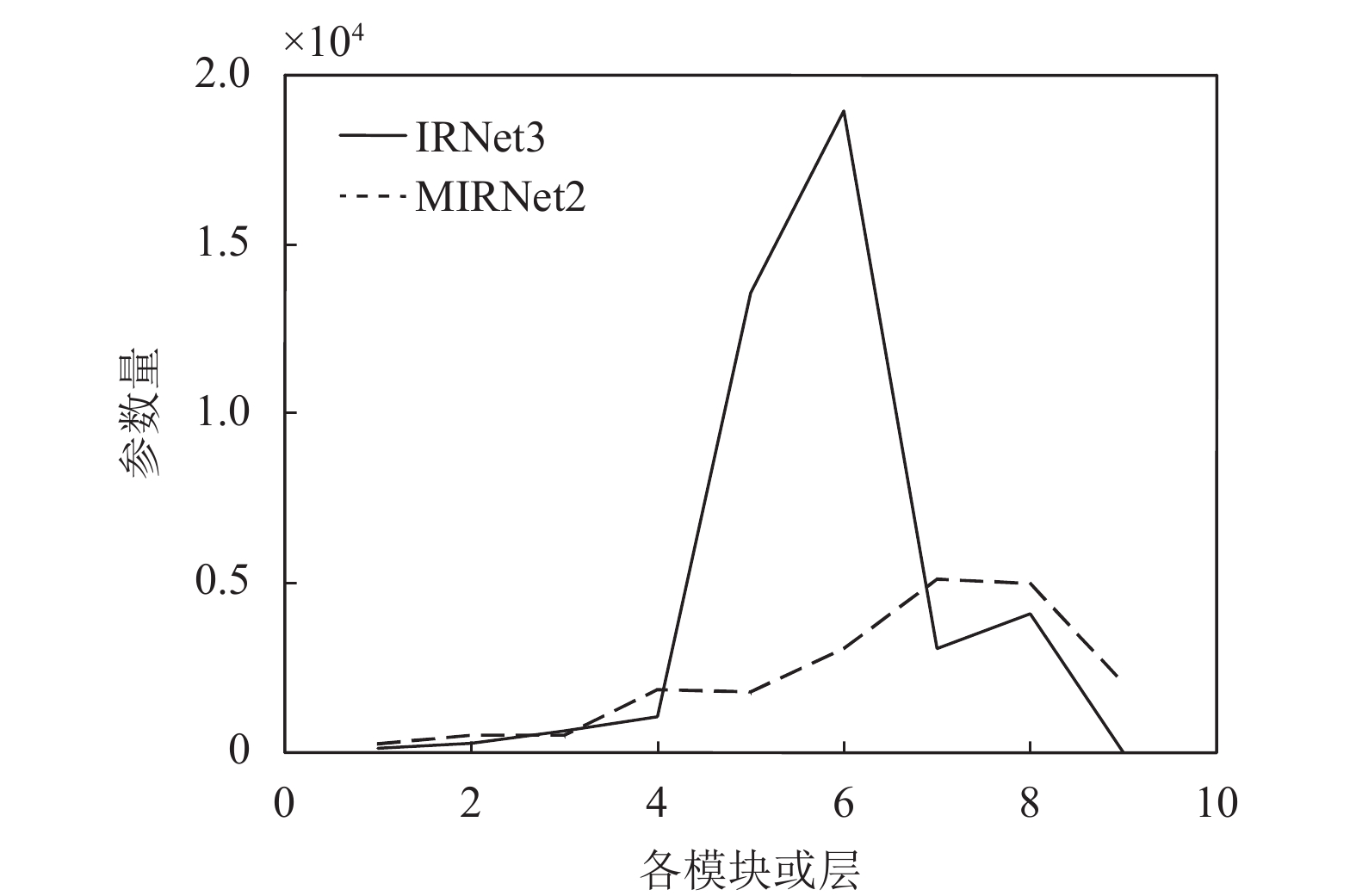

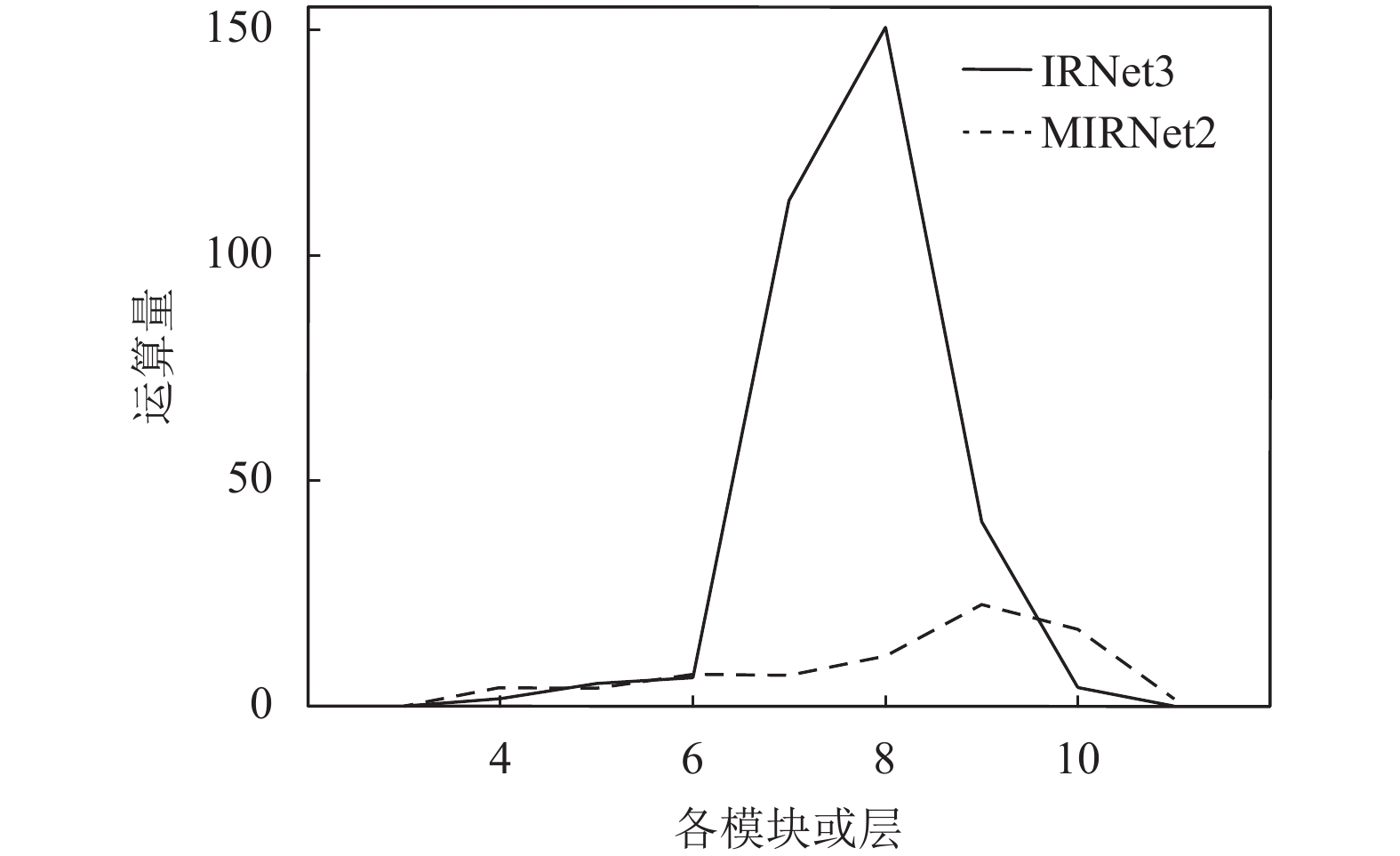

IRNet: 相比于ResNet1和GoogLeNet2, IRNet1和IRNet2的分类性能更优, 表明网络融合可以吸收各网络的优势. IRNet之间, IRNet3最优, 准确率是86.98%, 接近ResNet2的准确率, 但γ高出了0.97%, 避免识别失败的能力较好. 图12中, 对比ResNet2、GoogLeNet2和IRNet3, ResNet2是三者中最深且复杂的, 准确率达到稳定状态的时间较长; GoogLeNet2的结构相对简单, 特征提取效果在开始时优于ResNet2, 但稳定后的准确率低于ResNet2; IRNet3, 较快达到稳定的准确率, 得益于Inception模块的高效稀疏结构, 减少了参数量和运算量, 保证了特征提取的多样性. 如表3所示, res3(a,b,c,d) 和res4(a,b,c)是参数量和运算量增加的主要模块. 二者在稳定状态的准确率接近, 但IRNet3对样本的测试准确率较稳定, 提高了融合网络的鲁棒性. 当继续增加Inception 模块和残差模块时, 训练发生中断.

| 表 3 IRNet3的参数量和运算量 |

MIRNet: 主要有两个改进网络MIRNet1和MIRNet2. 如表3、表4、图14和图15所示, IRNet3前4个层或模块的参数量和运算量分别是2096个和13.1235 MFLOPs, MIRNet2前4个层或模块的参数量和运算量分别是3136个和14.9935 MFLOPs, 均大于IRNet3, 是因为MIRNet2使用的卷积核比IRNet3更大, 这使得MIRNet2后面的层或模块的输入特征面减小, 为网络总参数量和总运算量降低奠定了基础. MIRNet2的总参数量和总运算量分别是IRNet3的0.483倍和0.230倍, 残差模块是IRNet3参数量和运算量增大的主要原因. 然而, 这并未影响网络的分类性能, 如图11所示, 在训练起始阶段, MIRNet2的准确率上升快于IRNet3, 归因于改进模块pool3/conv3和conv4_1~conv4_5等极大地减少了参数量和运算量; 在整个训练过程中, MIRNet2的准确率高于IRNet3, 只在部分区域接近, 得益于改进的Inception模块(MIM1和MIM2)及池化模块(RM1和RM2). 表2中, MIRNet2的准确率是87.84%, 分别比IRNet3和ResNet2高出0.86%和0.87%, γ分别比IRNet3和ResNet2高出1.01%和1.98%, 算法避免失败的能力有所提高, 测试性能更加稳定. 综合分析图11和图13, MIRNet2的准确率优于ResNet2和GoogLeNet2, 表明改进的融合网络比使用单一核心模块的网络性能更优; MIRNet2的准确率高于IRNet3, 表明改进模块对提升融合网络的性能很重要, 网络融合不能仅借鉴原有的残差模块和Inception模块, 需要改进核心模块、网络结构等, 否则并不能充分发挥网络融合的优势. 改进的Inception模块及池化模块, 能提取不同层次的高阶特征和前后文的相关性特征, 保持了较少的参数量和运算量; ReLU是改进模块中每个分支的最后一层, 训练中自动调节梯度衰减, 进而影响各分支网络的特征提取, 增加对特征的高阶变换, 而不损害重要特征的完整性, 使更多在低维空间线性不可分的特征在高维空间线性可分. 这些提高了融合网络对脉搏波的分类性能.

| 表 4 MIRNet2的参数量和运算量 |

|

图 14 各模块或层的参数量 |

4 结论与展望

为推动计算机辅助脉诊的临床应用, 需要提高脉搏波识别的准确率. 通过主波提取、划分周期和制作hdf5数据集, 获得Caffe可处理的hdf5格式的脉搏波数据集. 研究了CNN9、CNN16、ResNet1、ResNet2、GoogLeNet1、GoogLeNet2、GoogLeNet 3及深度融合神经网络IRNet1、IRNet2、IRNet3和MIRNet1等, 根据脉搏波数据特点和其他网络的实验分析, 提出MIRNet2, 其分类性能最优, 准确率和约登指数分别是87.84%和75.90%, 改造的残差模块pool3/conv3和conv4_1~conv4_5大幅减少了参数量和运算量, 改进的Inception模块和池化模块, 能提取不同层次的高阶特征和前后文的相关性特征, 是MIRNet2性能提升的关键. 当网络加深时, 跳跃连接和层间稀疏连接有利于加速网络训练和避免梯度爆炸; 当网络层数接近时, 适当加宽网络, 有利于提取更丰富的特征. 但是, 要防止过多的层间连接和多个复杂模块直接相连, 否则将梯度爆炸或训练中断. MIRNet2的分类性能优于现有的脉搏波识别方法, 相比于Hu提出的CNN(9L)的准确率和约登指数, 分别高出15.53%和31.27%, 有较大提升, 将MIRNet2嵌入到云计算平台来识别健康和亚健康的脉搏波, 这是一个可行的应用场景[17]. 然而, 关于脉搏波标准数据集构建、GAN及其融合网络用于脉搏波识别等问题尚未解决, 这些是未来需要深入研究的方向.

|

图 15 各模块或层的运算量 |

| [1] |

LeCun YL, Bottou L, Bengio Y, et al. Gradient-based learning applied to document recognition. Proceedings of the IEEE, 1998, 86(11): 2278-2324. DOI:10.1109/5.726791 |

| [2] |

Krizhevsky A, Sutskever I, Hinton GE. ImageNet clas-sification with deep convolutional neural networks. Proceedings of the 25th International Conference on Neural Information Processing Systems. Lake Tahoe, NV, USA. 2012. 1097–1105.

|

| [3] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition. arXiv pre-print arXiv: 1409.1556, 2015.

|

| [4] |

Szegedy C, Liu W, Jia YQ, et al. Going deeper with convolutions. Proceedings of 2015 IEEE Conference on Computer Vision and Pattern Recognition. Boston, MA, USA. 2015. 1–9.

|

| [5] |

He KM, Zhang XY, Ren SQ, et al. Deep residual learning for image recognition. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016. 770–778.

|

| [6] |

Liu D, Wang ZW, Fan YC, et al. Learning temporal dynamics for video super-resolution: A deep learning approach. IEEE Transactions on Image Processing, 2018, 27(7): 3432-3445. DOI:10.1109/TIP.2018.2820807 |

| [7] |

Khosravi P, Kazemi E, Imielinski M, et al. Deep con-volutional neural networks enable discrimination of heterogeneous digital pathology images. Ebiomedicine, 2018, 27: 317-328. DOI:10.1016/j.ebiom.2017.12.026 |

| [8] |

Vesal S, Ravikumar N, Davari A, et al. Classification of breast cancer histology images using transfer learning. Proceedings of the 15th International Conference on Image Analysis and Recognition. Póvoa de Varzim, Portugal. 2018. 812–819. [doi: 10.1007/978-3-319-93000-8_92]

|

| [9] |

Zhang RY, Wang QQ, Lu Y. Combination of ResNet and center loss based metric learning for handwritten Chinese character recognition. Proceedings of the 14th IAPR International Conference on Document Analysis and Recognition. Kyoto, Japan. 2017. 25–29. [doi: 10.1109/ICDAR.2017.324].

|

| [10] |

Lu Z, Jiang XD, Kot A. Deep coupled ResNet for low-resolution face recognition. IEEE Signal Pro-cessing Letters, 2018, 25(4): 526-530. DOI:10.1109/LSP.2018.2810121 |

| [11] |

Hahibzadeh M, Jannesari M, Rezaei Z, et al. Auto-matic white blood cell classification using pre-trained deep learning models: ResNet and inception. Proceedings Volume 10696, Tenth International Confer-ence on Machine Vision. Vienna, Austria. 2017. 1–8. [doi: 10.1117/12.2311282]

|

| [12] |

Szegedy C, Ioffe S, Vanhoucke V, et al. Inception-V4, Inception-ResNet and the impact of residual connec-tions on learning. 2017 31st AAAI Conference on Artificial Intelligence. San Francisco, CA, USA. 2017. 4278–4284.

|

| [13] |

Zhuang NF, Ye J, Hua KA. Convolutional DLSTM for crowd scene understanding. Proceedings of 2017 IEEE International Symposium on Multimedia. Taichung, Taiwan, China. 2018. 61–68. [doi: 10.1109/ISM.2017.19]

|

| [14] |

Hu XJ, Zhu HH, Xu JT, et al. Wrist pulse signals analysis based on deep convolutional neural networks. Proceedings of 2014 IEEE Conference on Computational Intelligence in Bioinformatics and Computational Biology. Honolulu, HI, USA. 2014. 1–7.

|

| [15] |

Zhang SR, Sun QF. Human pulse recognition based on convolutional neural networks. Proceedings of 2016 International Symposium on Computer, Consumer and Control. Xi’an, China. 2016. 366–369. [doi: 10.1109/IS3C.2016.101]

|

| [16] |

Zhou FY, Jin LP, Dong J. Premature ventricular con-traction detection combining deep neural networks and rules inference. Artificial Intelligence in Medicine, 2017, 79: 42-51. DOI:10.1016/j.artmed.2017.06.004 |

| [17] |

Jin LP, Dong J. Intelligent health vessel ABC-DE: An electrocardiogram cloud computing service. IEEE Transactions on Cloud Computing, 2018, 6: 1-14. DOI:10.1109/TCC.2018.2825390 |

| [18] |

Ioffe S, Szegedy C. Batch normalization: Accelerating deep network training by reducing internal covariate shift. Proceedings of the 32nd International Conference on Machine Learning. Lille, France. 2015. 448–456.

|

| [19] |

Szegedy C, Vanhoucke V, Ioffe S, et al. Rethinking the Inception architecture for computer vision. Proceedings of 2016 IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA. 2016. 2818–2826. [doi: 10.1109/CVPR.2016.308]

|

2019, Vol. 28

2019, Vol. 28