20世纪90年代, 中科院陆汝钤院士在国际上初次提出全过程计算机辅助自动生成动画技术[1], 尝试将人工智能领域的理论应用到动画的自动生成过程中. 2008年中科院张松懋研究员创造性的提出将全过程计算机辅助动画自动生成技术应用到手机短信中来, 即手机短信3D动画自动生成系统. 该系统底层以图形学技术为支撑, 在上层应用人工智能技术结合电影艺术指导, 将手机短信转化为一段表达短信主题的简短三维动画, 发送给接收方. 现代通信技术3G、4G的发展更为此项目的实现提供了良好的网络环境. 作为传达动画主题的直接方式, 摄像机运动规划是手机3D动画自动生成系统的重要环节之一.

虚拟摄像机运动规划[2]需要在实现无障碍拍摄的前提下, 引导观看者的注意力, 向观看者呈现动画的主要内容, 是三维场景动画不可缺少的一部分. 虚拟摄像机的自动规划涉及到虚拟现实、人工智能、人机交互以及摄影艺术等多个学术领域范围[3], 是动画自动生成课题研究中的重点和难点. 早在20世纪80年代就有相关研究人员对其进行了深入的研究和探索. 归纳起来, 现有的相关研究主要分为三种类别: (1) 基于数值计算方法. 早在1988年, Blinn[4]便提出了该方法, 其可以精确地计算出摄像机的空间属性取值, 但无法解决虚拟空间内物体间的遮挡检测问题; (2) 交互式方法. 在1992年, Phillips借助人机交互形式建立了可以部分实现自动设置摄像机属性的系统“Jack”[5]. 系统首先自动生成一幅初始图片, 由用户给出对该图片的评价, 并藉由系统所提供的相应指令辅助计算机修改或调整摄像机的空间属性具体值. (3) 基于约束满足与最优化的方法[6]. 根据预定义的约束与目标函数求解计算摄像机的具体属性值. 在三维动画中摄像机自动生成领域的研究, 以陆汝钤院士主导完成的“Swan”系统[1]为主, 其基于语义网知识库中的本体库与规则库分层推理模式的摄像机自动生成部分在摄像机自动生成方向的研究有指导性作用.

语义网是依据万维网联盟 (W3C) 的标准对万维网的延伸, 本体作为语义网信息组织的语义支撑, 本身具有的丰富的表达能力不但能用来描述领域范围的概念模型, 同时也是对知识进行推理和验证的基础[7]. 本体被用作概念化的本质表示, 赋予网络上的信息以语义含义, 以计算机可处理的形式定义相关领域范围的术语和关系, 并利用这些术语和关系构成该领域的规则集合, 实现领域知识的共享和重用. 本体应用的研究领域非常广泛, 包括知识管理、信息集成、智能信息检索、数字图书馆、网络教学、企业本体、机器翻译等应用. 国家“973”计划、国家自然科学基金等项目中的信息集成、数字图书馆、信息检索等应用型技术均以Ontology作为核心技术. 国际上, 2007年2月, 由W3C的语义网教育及扩展工作组(Web Semantic Education and Outreach)支持的开放互联数据(Linking Open Data)[8]社区项目成立. 项目的目标是将开放数据集用RDF格式重新发布在互联网上, 并创建数据间的相互链接, 是语义网中非常有名的社交应用[9].

手机3D动画自动生成系统至今已经对摄像机规划实现三个版本的改进: 潘旭光首次提出在手机动画系统中进行摄像机规划[10], 实现摄像机的自动生成与简单目标拍摄方式. 刘畅在其基础上结合本体知识库, 实现镜头拍摄规划与镜头组接规划. 许向辉在定量计算部分设计实现摄像机障碍物检测与规避算法, 并设计目标可见性判断方法对障碍物进行二次检测. 但是总结系统原有的摄像机规划, 其中定性规划只是基本镜头的简单组合, 未深入探索镜头组合之间的语义关联问题, 导致动画的表现力有一定局限, 无法做到正确的情节导向作用. 并且镜头组合规则没有被显式刻画出来, 而是通过程序嵌入形式执行, 方式不够灵活, 同时不利于知识的扩充.

本文借鉴陆汝钤院士在“Swan”系统中提出的自上而下定性分层设计理念, 结合语义网在知识共享和资源重用方面的优势和学者们的广泛研究和应用, 在手机短信3D动画自动生成系统中采用了基于语义网络的本体这一技术来实现摄像机导演知识库系统的构建. 在阅读总结摄影领域经典书籍文献[11,12]后, 将该领域成熟摄影手法概念运用到系统中生成摄影规则. 在原摄像机规划基础上首次提出基于语义网络技术构建摄像机导演知识库系统, 设计摄像机定性规划高级摄影原语和原语镜头属性两层规则推导, 实现开放式短信测试中摄像机拍摄方式的主题相关性, 拍摄方式的多样性和丰富性. 同时基于导演知识库的摄像机规划也有利于摄影风格的变迁和摄影知识的扩充, 提高知识的复用性.

本文首先概述课题的研究背景, 其次详细介绍了我们通过斯坦福大学开发的Protégé[13]系列3.4.4创建的摄像机导演知识库中知识库和规则库的组织结构以及系统中摄像机定性规划的具体实现和定量规划大致流程, 最后设计评估实验分析实验结果并总结结论.

2 摄像机导演知识库 2.1 摄影领域知识总结Arijon在《Grammar of the Film Language》中曾提到“一切语言都是某种既定的成规, 一个被社会承认的, 教会它的每一个成员来解释的某些具有完整含义的符号. 讲故事的人或思想家应当首先学会这些符号以及组合规律”. 电影作为一种视觉交流的媒介, 其发展史是和电影语言表达现实的能力直接相关的. 然而现实性是一种与时俱进的概念, 是一种处于不断发展的感性认识的形式[11]. 因此将电影工作者的创作思维过程理论化是一个需要持续研究课题. 但我们可以总结出电影语法的基本元素以及电影工作者成熟的拍摄技巧. 例如, 场景概念可以由人物有无对话和动作进行定义[14], 进一步又可以通过人物的群体数量区别; 镜头定义是摄像机拍摄的连续图像, 可以有定镜头, 推拉镜头, 移镜头等; 一个场景可能会由多个镜头组成等等.

本文归纳总结出电影语法的3个重要元素:

(1) 拍摄距离

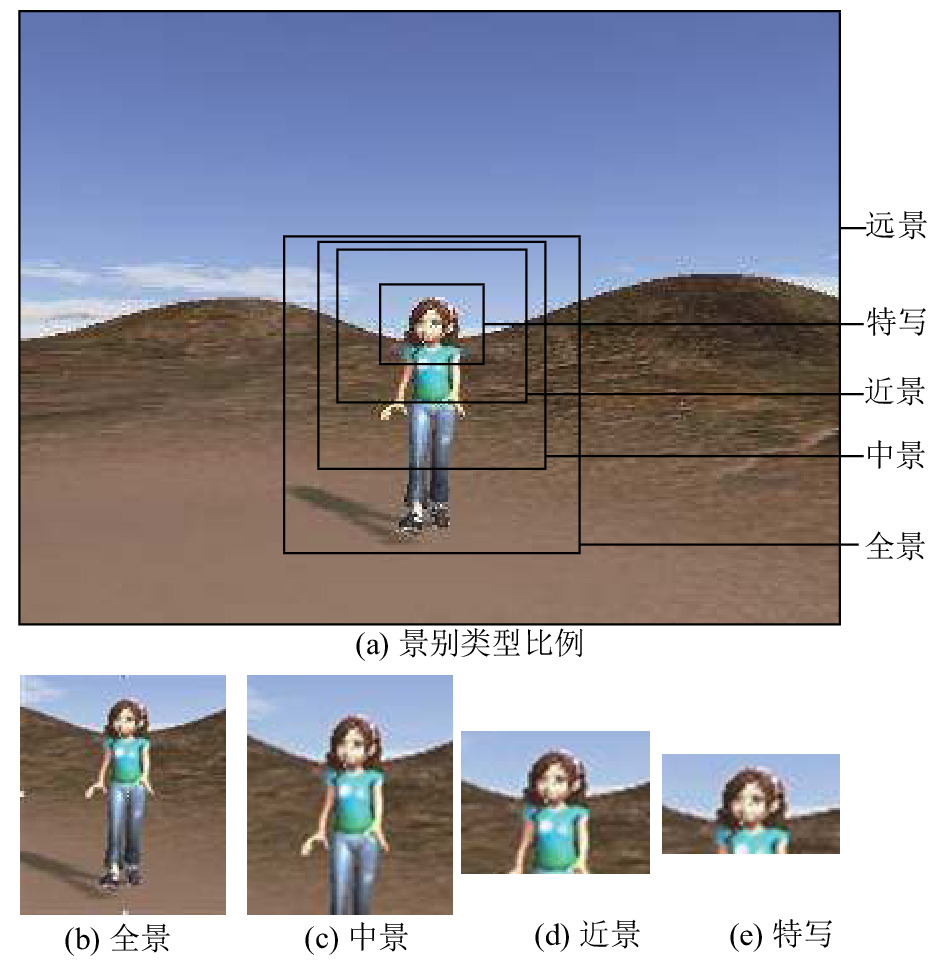

在动画中, 只要保证虚拟摄像机未进入拍摄目标模型空间内部, 并且在其最近可视平面和最远可视平面之间, 则摄影机和拍摄对象间的距离是不受限制的[15]. 从真实世界的拍摄实践中我们可分出5种有明显区别的基本距离, 分别是: 特写, 近景, 中景, 全景和远景. 五个类别并没有规定具体情况下的绝对距离. 例如, 分别拍摄一座房子和一个人物的近景, 拍摄距离肯定是不同的. 这些术语主要表达的是概念上的定义, 有相当的伸缩性. 如下图1所示为摄影机拍摄人物时不同景别示例图.

|

图 1 人物拍摄景别示例 |

(2) 剪辑类型

每个场景都有三种基本的剪辑方法: 1)一个主镜头记录整个场景, 该主镜头可以采取任意一种拍摄方式, 例如定镜头, 推镜头, 拉镜头等; 2)一个主镜头与其他短镜头交切, 例如, 可以定镜头和推镜头组合, 作为副镜头的推镜头穿插在主镜头中, 强调场景的关键情节; 3)两个或更多的主镜头平行地交织在一起, 这种形式可以实现各主镜头视角交替拍摄. 导演或摄影师在表现一个场景时, 可以运用这三种方法中的一种或全部方法.

(3) 场景的匹配

一个场景中的多个镜头需要做到位置、动作的匹配. 电影播放是固定的平面, 如果一个模型的全景展现在视角的左侧, 那么在切换至同一视轴的其他镜头时, 人物必须仍在视角的同一侧. 否则, 就会出现笨拙的视觉上的跳动, 使观众厌倦分神. 动作的匹配亦是如此, 在记录人物连贯动作的两个镜头中, 动作方向要一致, 否则会导致观众混淆动作的运动方向, 从而带来错误的视觉效果.

陆汝钤院士在《Automatic Generation of Computer Animation》中提出在“Swan”中类比软件工程设计的5个阶段将虚拟摄像机规划分为5个层次[16], 分别是: 导演规划需求分析(DPRS), 摄像机语句规则(RCS), 高级摄影原语声明(HLCP), 基本摄影原语定性(BCP), 摄像机定量语句(QCP). 本系统构架较“Swan”简单, 设计多层概念会带来不必要的冗余. 因此本文基于系统自身特点提出摄像机规划的两层结构, 完善拍摄手法和拍摄镜头规则推导.

摄像机导演知识库是手机短信3D动画自动生成系统的重要组成部分, 它的功能主要包括: 1) 把导演或摄影师等领域研究员总结出来的知识概念在知识库中以本体库和规则库的形式显示描述出来并进行存储. 2) 根据动画场景定性规划模块中主题、人物、动作表情的各自特性, 在本体库和规则库中由推理机推理, 得到应该对应采取的拍摄手法, 包括该场景拍摄需要的镜头, 镜头的拍摄目标, 摄像机的位置, 旋转, 景别属性[14]等, 并将这些信息以特定的形式输出给动画系统的下一个部分.

2.2 导演知识库结构将摄影领域知识体现在导演知识库中, 包括两个部分: 摄像机本体库和导演知识规则库, 规则推理基于这两个部分运行, 得到摄像机定性规划需要的信息. 其中关于摄像机属性和高级摄影原语等类(概念)和实例的信息体现在本体库上, 提炼总结的各种规则存储在规则库中.

2.2.1 摄像机本体库领域知识中的本体是指和知识内容相关的一组概念化的规范说明, 描述了组成主题领域的词汇表的基本术语及其关系, 以及结合这些术语和关系来定义词汇外延的规则[17]. 摄像机本体库分为三大类, 摄像机镜头, 镜头属性, 摄像机摄影原语.

(1) 摄像机镜头类

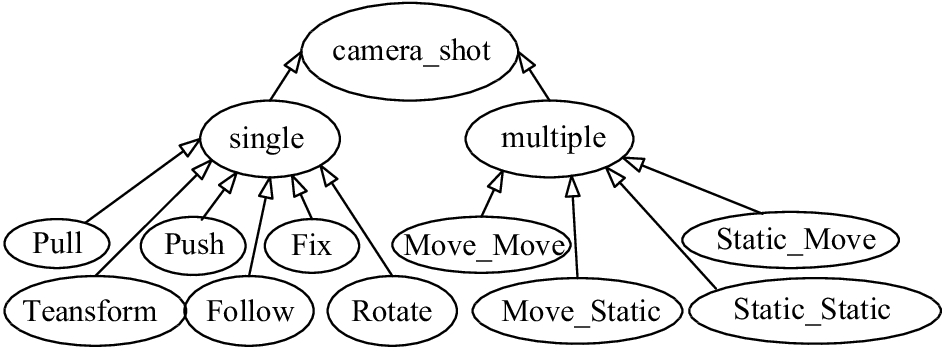

我们所构建的摄像机镜头领域本体camera_shot依据短信动画时间短小精炼的特点, 将基本镜头组合分为单镜头和多镜头两类. 单镜头下分为基本的定、推、拉、移、转、跟等6大类. 多镜头现主要指两个镜头, 后续系统会根据摄影领域专家对知识的总结归纳继续扩展. 多镜头下又细分动动、静静、动静和静动4种镜头运动组合方式. 摄像机镜头类本体库如图2所示.

|

图 2 摄像机镜头本体库 |

(2) 摄像机属性定义

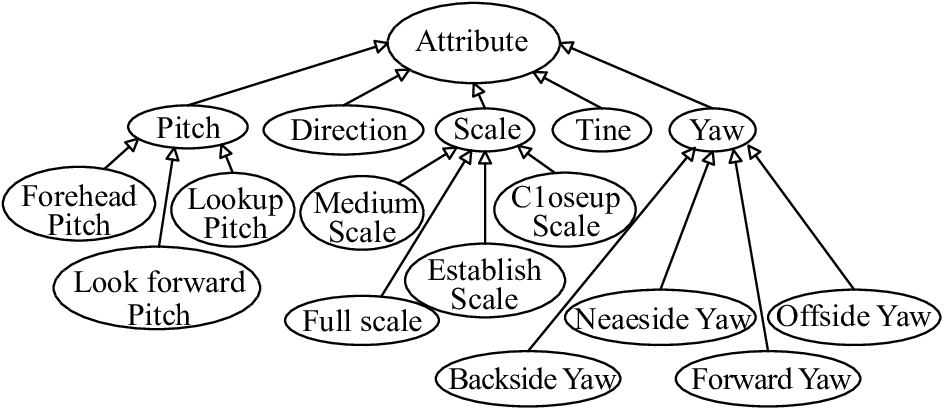

组织摄像机空间拍摄数据属性描述, 以供知识库规则推理的调用. 镜头属性类包括摄像机镜头旋转方向Yaw, 俯仰角度Pitch, 景别类型Scale, 镜头拍摄时长Time四大基本类型. 旋转方向又分左右前后四类, 俯仰程度分俯视, 平视, 仰视三类, 景别类型分近景, 中景, 远景和全景. 摄像机属性本体库如图3所示.

|

图 3 摄像机属性本体库 |

(3) 摄像机高级原语类

摄像机导演知识库还包括系统整理的涉及摄像机拍摄手法的摄像机高级原语HLCP (High Level Camera Primitive)本体库. 根据短信动画场景的特点, 以场景中定性规划的人物数目作为场景分类依据, 所有的场景均可以分为四大类, 分别是单人场景, 两人物对话场景, 多人群体场景和人物无关场景, 高级摄影原语的分类与其一一对应, 分别是SingleModelSceneHLCP、TwoPeopleSceneHLCP、MultipleModelSceneHLCP、UnRelatedHLCP, 各类下细分对应场景的原语, 进一步定义各拍摄手法的镜头组合参数. 附录A给出摄像机高级原语类名和释义. 例如人物对话TwoPeopleSceneHLCP下分为外反拍、内反拍、直角拍摄、主观拍摄、过肩拍摄五种手法. 摄像机高级摄影原语知识立足于摄影理论从导演和摄影师角度总结提炼的实践中拍摄技巧, 可以将此基本单位应用到拍摄特定的环境场景和人物. 例如, 知识库中的In_Contra和Out_Contra原语, 经常用于拍摄两人物面对面交流的对话场景; Right_Angle习惯应用在两人物对话场景, 但是不同点是, 此时人物的相对方向为垂直. Parallel3被用来描述场景中多类权重相同的拍摄目标的场景类型; Coaxile3用来强调拍摄的渐进或是渐远效果等. 通过在系统中添加高级摄影原语类, 可以将导演以及摄影师的拍摄技巧和手法应用到系统的摄像机拍摄中, 强调拍摄的美学和合理性[18]. 摄像机高级原语本体库结构如图4及表1所示.

|

图 4 摄像机高级原语本体库 |

| 表 1 高级摄影原语类名和释义 |

2.2.2 导演知识规则库

导演知识规则库是该版摄像机定性规划的核心, 是对真实导演和摄像师知识的总结与提炼, 并运用结构化的模式进行存储, 为定性规划的规则推导提供了理论基础的支持. 规则库分为高级摄影原语规则和镜头属性规则两类.

(1) 高级摄影原语规则库

高级摄影原语规则主要负责推理定义各具体场景类型对应具体合适的拍摄手法, 规则前件涵盖手机3D动画系统中的大部分动态生成场景类别. 短信动画情节定性规划的主题、人物、人物交互动作、场景类型、模型、模型种类等信息作为导演知识库的输入, 经高级摄影原语规则推理出适合该场景的拍摄手法的具体实例以及该实例包括的具体镜头和他属性值. 例如拍摄两人物面对面的过肩手法原语, 可以选择一个定镜头或是定镜头和推镜头两个来拍摄, 同时保证画面人物的过肩拍摄比例特性关系. 过肩手法如表2所示. CameraSWRL_HLCP_OverShoulder规则前件中AddModelRelated属性表明如果已知场景中添加x、y两个模型, isTemplateObject属性表明模型均为目标, Human说明模型为人物, 且知识库中存在过肩手法类实例, 那么这条短信的各前提条件符合选用过肩手法拍摄, 并且在规则后件中用HLCPTargets属性声明该HLCP的拍摄目标即为x, y.

(2) 镜头属性规则库

镜头属性规则为上述高级摄影原语层拍摄手法实现所需镜头的属性具体描述. 各类拍摄手法中的镜头有镜头旋转方向、俯仰角度、镜头景别、镜头所占动画时长定性比例、镜头拍摄目标共五种参数选择, 各参数值设置需适应具体短信的输入. 因此, 镜头属性规则库的实现不拘泥于统一特定的拍摄规则, 始终处于不断修改与完善阶段. 系统中过肩手法高级摄影原语原语对应的镜头属性设置规则如表3所示. 例如, CameraSWRL_Shot_OverShoulder_1规则前件定义了该过肩手法实例包括一个定镜头(Fix), 因为是单镜头拍摄整个场景, 因此镜头的时长占据动画全部(AllTime), 景别选取最大景别远景(EstablishScale), 摄像机在人物正前方(ForwardYaw), 俯仰方向为平视(ForeheadPitch)拍摄人物.

现知识库中共有HLCP规则13条, 镜头属性规则具体方案27条. 规则的种类和数量一直在随着系统的运行和知识的积累不断修改完善和扩展.

| 表 2 高级摄影原语规则OverShoulder示例 |

| 表 3 OverShoulder原语对应的镜头属性规则 |

3 基于导演知识库的摄像机规划 3.1 定性规划的实现

摄像机定性规划方案中采取两层规则推理.

第一层, 经高级摄影原语层的规则推理, 选择合适拍摄手法; 情节定性规划后, 动画场景的主题、目标模型、模型种类、数量、动作、表情等参数需作为导演知识库推理机的输入, 经高级摄影原语层的规则推理, 得到符合规则的拍摄手法. 因规则前件的覆盖关系, 可能会存在多条符合规则的手法, 此处记录知识库中符合条件的所有拍摄手法, 作为本次短信备选拍摄方案, 全部遍历完后, 随机选择合适的一条拍摄手法规则执行.

第二层, 选择与上层拍摄手法对应的拍摄镜头组合; 经上层的推理, 已知此动画场景需要使用的高级摄影原语, 以及摄影原语内定义的镜头类别及拍摄目标, 在镜头属性规则库中选择出所有匹配已选定拍摄手法的所有规则, 随机选择一条执行.

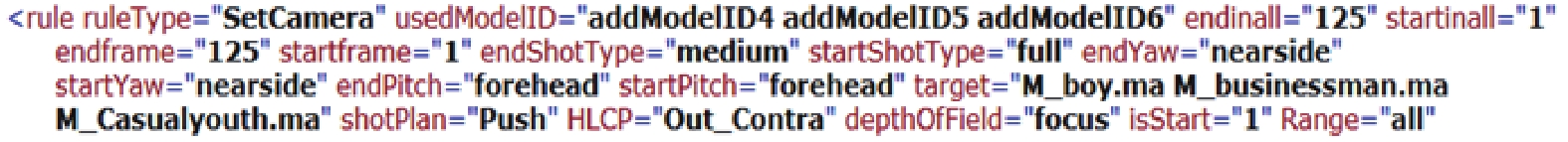

最后, 知识库规则推导完毕后, 生成摄像机定性规划数据, 写入总体定性规划的ADL文档, 若在第一层中, 没有找到相应HLCP规则, 则执行原版摄像机规划方案. 摄像机定性规划数据格式规定了摄像机的拍摄目标, 拍摄起始、结束帧, 景别, 俯仰角度, 旋转方向等属性, 例如图5所示, 表示在第1帧到第125帧, 摄像机newCameraA采用外反拍手法, 手法中Push镜头在左侧(nearside)拍摄模型M_boy、M_bussinessman、M_Casualyouth集合, 景别ShotType由全景(full)变为中景(medium).

|

图 5 摄像机定性输出格式示例 |

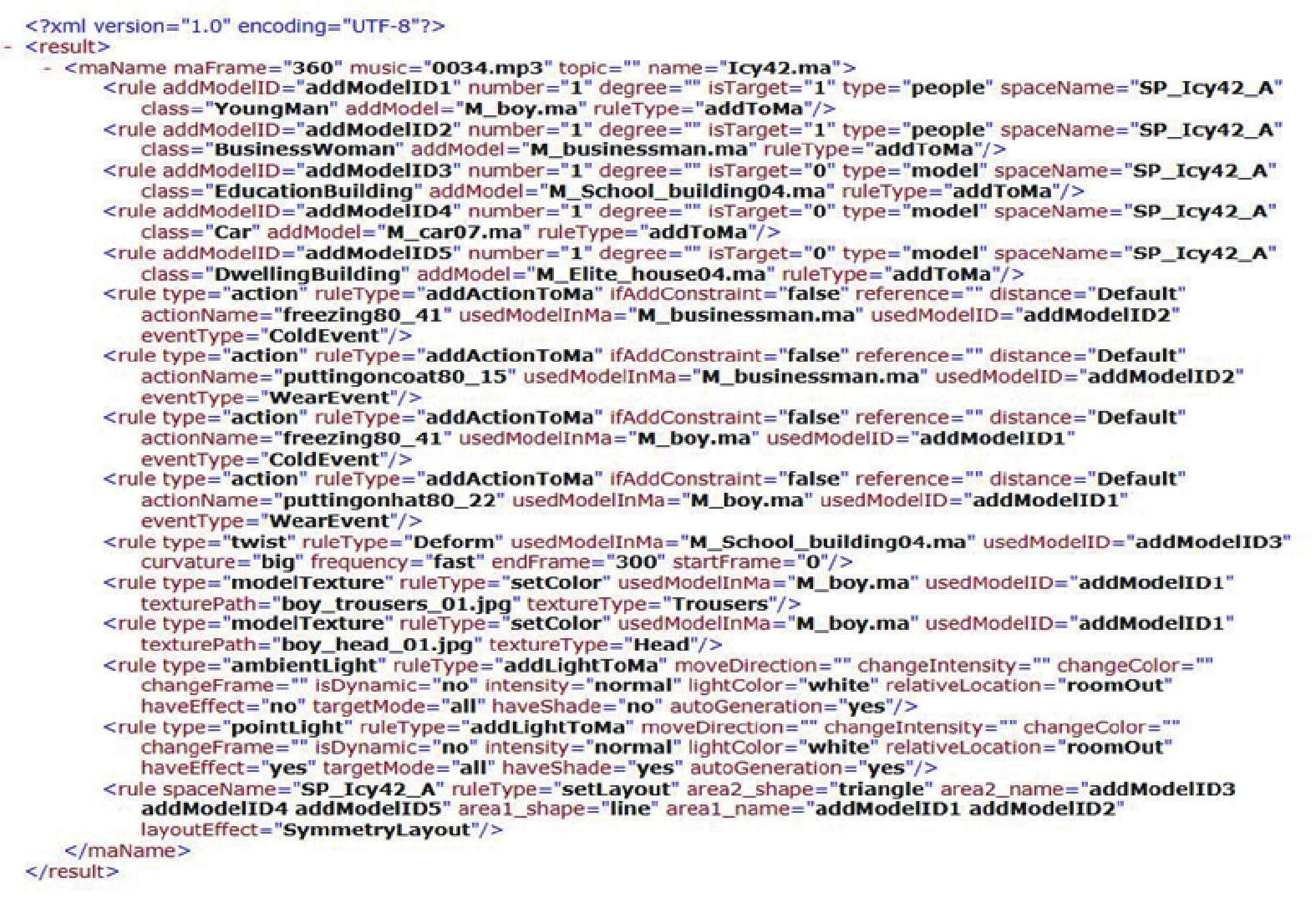

以短信“出去转转, 外面太冷了”为例, 说明知识库系统如何基于本体库和规则库运行推理. 首先, 经过系统的布局、交互动作、材质、灯光定性规划后得到ADL信息如图6所示. 知识库中此时也保存有该短信的定性规划信息. 已知该场景添加有M_boy、M_ bussinessman、M_School_building04、M_car07四个模型, 并且可以得知前两个模型为情节规划得出的目标模型, 且这两个模型为人物. 最终我们得到需要作为拍摄目标的两个人物模型, 并且可以获取两个的模型ID. 因为此时的条件, 已经满足表2中Over_Shoulder摄影原语规则的前件, 因此选择执行CameraSWRL_ HLCP_OverShoulder.

|

图 6 短信“出去转转, 外面太冷了”情节定性规划输出文档 |

从表3中得出Over_Shoulder原语共有四种对应镜头属性规划规则, 定性程序随机选取一条规则CameraSWRL_Shot_OverShoulder_3执行, 得到如图7所示的摄像机定性规划输出.

|

图 7 短信“出去转转, 外面太冷了”摄像机定性规划文档 |

3.2 定量规划的实现

在生成的动画场景中寻找虚拟摄像机运动路径之前, 首先需进行场景预处理对静态的动画场景进行建模. 动画场景中的模型主要有障碍物模型和地形模型, 这些模型均利用Maya多边形建模技术制作, 其中障碍物由几何体表示, 地形由网面表示, 它们的表现形式有很大差异. 场景建模的目的就是对整个场景用一个标准方式描述, 将障碍物、地形等全部信息统一表达.

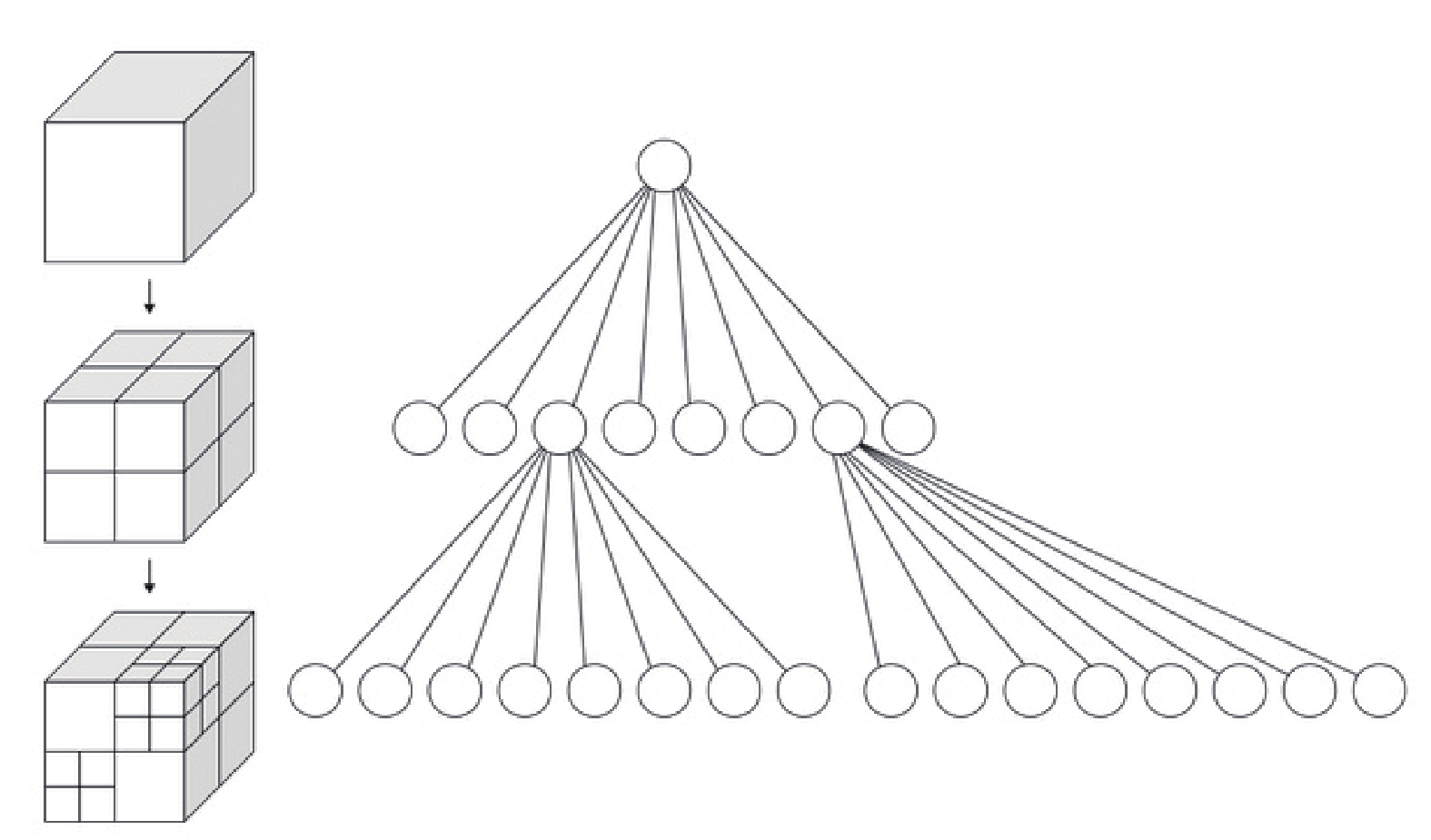

在三维空间建模中, 八叉树数据结构是场景划分中的常用方法, 其用层次方式组织三维空间区域[19,20]. 近年来被广泛应用于数据存储、三维重建、虚拟现实、地理信息系统、图像处理等领域中. 八叉树的根节点代表整个场景, 其他每个节点表示立方体积中包含的空间, 通常称为体素[21]. 节点可递归细分为八个子节点, 直到达到给定的最小体素大小, 或是递归大于指定深度. 最终生成的八叉树中节点可分为三类: 黑节点, 它所对应的立方体全为模型所占据. 灰节点, 它对应的立方体部分地为模型所占据; 白节点, 它所对应的立方体中无模型内容. 其中可递归划分的为灰节点, 黑节点和白节点作为八叉树的叶子节点存在. 本文在八叉树节点中定义的各个分量分别保存对应体素的最小和最大空间坐标、节点所在层次、是否为灰节点、以及8个子节点数据集等信息. 如图8所示为空间的八叉树递归划分和对应生成的八叉树示例.

|

图 8 空间八叉树递归划分和对应生成八叉树[19] |

本文采用八叉树结构对场景进行预处理, 把每个自由网格作为连接图的节点, 根据网格的邻接关系构建连接图用于路径规划. 场景划分算法执行时包括将八叉树的单位结点分别标记障碍单元或自由单元, 路径规划规定摄像机只能在相邻自由单元中移动. 首先通过八叉树的空间节点与模型的AABB (Axis Align Bounding Box)包围盒进行相交检测, 确定需要做进一步检测的八叉树障碍单元节点. 对障碍单元节点再次划分检测, 递归划分节点到满足设定条件(例如指定递归深度)从而确定所有的自由节点. 之后将八叉树面面相邻的自由单元的中心点分别相连, 构成连接图的节点, 计算出相邻单元连线的长度作为路径规划连接图的边权值. 我们选择图搜索中的路径规划IDA*算法, 在此连接图中找到一条路径, 使得路径经过的边的权值之和最小. 最后对摄像机旋转, 俯仰角度等属性进行优化处理.

4 实验评估与结果分析基于导演知识库的摄像机定性规划分层推理系统, 最主要的目的是借助于导演知识库构建的规则实例丰富和合理化摄像机的定性规划, 实现知识库的重复利用. 因此, 本次实验旨在测试导演知识库中规则对开放短信的覆盖率以及推理出的规则对应到具体短信的合理性和规则选择的丰富性.

(1) 测试规则覆盖率方面的实验数据选取系统在2017年九月至2017年十二月期间接收的成功渲染出动画的所有短信. 其中短信总数为298条, 摄像机定性规划结果如表4所示.

| 表 4 开放式短信测试摄像机定性规划结果 |

|

图 9 短信“刚买的东西就丢了, 气死我了”购物主题动画截图 |

由表4可得, 未执行摄像机规划的短信为103条, 占所有测试集34.56%. 同时表中给出未执行摄像机规划的两个主要原因: 1)情节定性规划时未向场景添加任何模型, 因此该场景无动态添加表达短信的模型, 仅需使用默认摄像机渲染; 2)动画场景为舞台背景场景, 因手机短信3D动画自动生成系统中存在少量舞台场景, 该类场景对摄像机运动幅度限制较大, 系统当前未对此类场景做摄像机动态规划, 暂时调用默认摄像机渲染. 成功执行摄像机规划的短信为195条, 占所有测试集的65.44%. 执行原版摄像机规划102条, 成功执行基于导演知识库的摄像机规划的短信为93条. 实验数据较多, 在此以短信“刚买的东西就丢了, 气死我了”为例, 说明成功执行基于导演知识库的摄像机规划时, 定性规划指定“Coaxile_3”摄影原语生成的动画如图9所示. 系统服务器开启时可正常访问的系统首页http://anim.bjut.edu.cn/3dsma/ReadMessage.html.

此次试验表明开放性短信测试中基于导演知识库的摄像机规划占所有成功执行摄像机规划短信数量的47.69%, 说明现有导演知识库规则已经有明显的成功, 但是该结果与预期效果仍有较大差距. 分析其中原因主要是系统导演知识库中规则覆盖面不够, 未能匹配系统动态生成的所有动画场景. 因此建立完整全面的导演知识库需要进一步的改进和扩展.

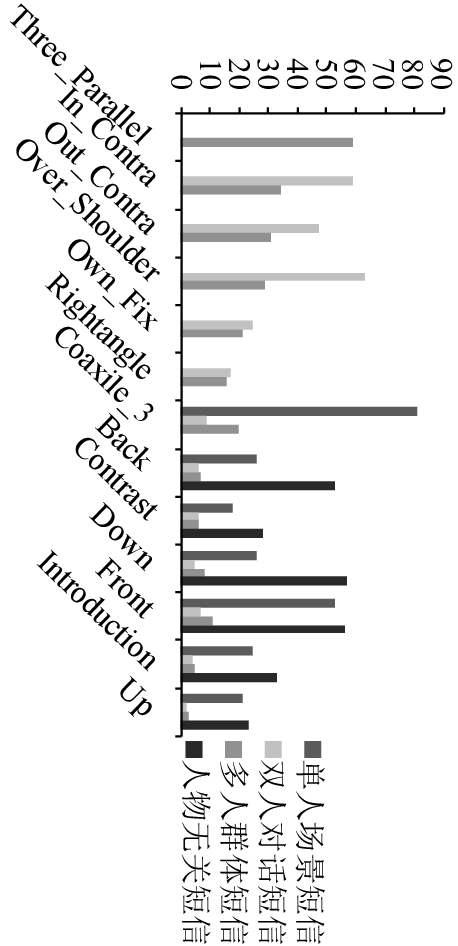

(2) 将上述实验(1)中所有成功执行新版摄像机规划的93条短信数据, 根据本文采取的场景中人物数目的分类依据先进行分类: 单人场景18条, 两人物对话场景28条, 多人群体场景38和人物无关场景9条, 为每类场景随机抽取5条短信, 在情节定性规划文档输出相同情况下, 重复执行50次摄像机定性规划. 实验数据如图10所示.

图中横轴为知识库中高级摄影原语实例, 纵轴为对应原语的测试短信数量. 分析表中数据可知, 单人场景短信对高级摄影原语的选择比较集中在识库中预先定义的单人场景拍摄原语类Coaxile_3; 双人对话场景短信对应原语主要分布在知识库中定义的双人摄影原语类In_Contra、Out_Contra、Over_Shoulder; 多人群体场景短信选择的摄影原语的取值范围比较广泛, 但知识库中预先定义的多人群体场景拍摄原语Three_Parallel为主导; 人物无关场景短信的拍摄原语均在知识库中定义的人物无关原语分类

|

图 10 四类场景对应短信摄像机定性规划实验结果 |

图10中横轴为知识库中高级摄影原语实例, 纵轴为对应原语的测试短信数量. 分析图10中数据可知, 单人场景短信对高级摄影原语的选择比较集中在识库中预先定义的单人场景拍摄原语类Coaxile_3; 双人对话场景短信对应原语主要分布在知识库中定义的双人摄影原语类In_Contra、Out_Contra、Over_Shoulder; 多人群体场景短信选择的摄影原语的取值范围比较广泛, 但知识库中预先定义的多人群体场景拍摄原语Three_Parallel为主导; 人物无关场景短信的拍摄原语均在知识库中定义的人物无关原语分类中选择.

根据以上分析可知, 测试短信动画场景推导出的摄影原语与知识库中按场景分类的摄影原语基本匹配, 因此可以总结导演知识库定性规划两层规则推导方式可以依据情节定性规划的结果为短信选择合适的高级摄影原语.

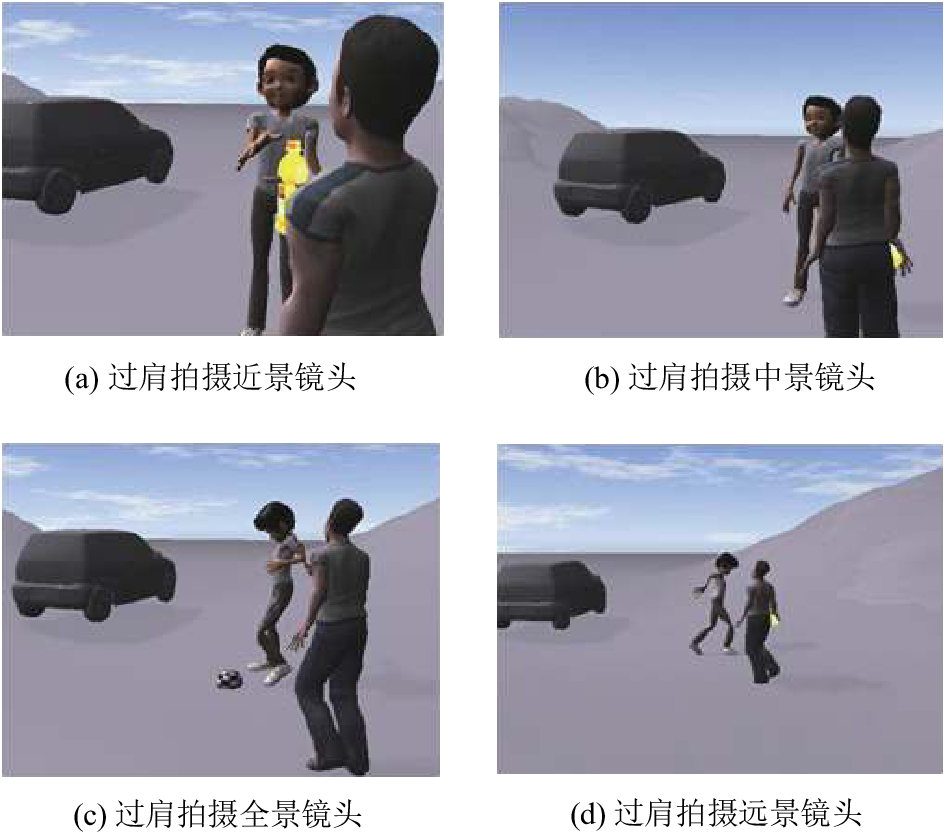

同一高级摄影原语可对应多种镜头属性规则. 镜头的景别分为4种、旋转角度可取值4种、俯仰角度Pitch枚举取值3种以及镜头占动画时长比例属性等, 均可影响镜头的属性规则. 由此可知导演知识库可在理论上实现短信动画摄像机规划的丰富性, 如图11所示, 为同一高级摄影原语过肩拍摄Over_Sholder原语下因景别属性不同带来的视觉区别. 但是在实践中, 系统仍需要不断的完善和扩充高级摄影原语和镜头属性规则.

|

图 11 过肩拍摄景别多样性实例 |

5 结论

本文介绍了手机短信3D动画自动生成系统中摄像机规划的作用和意义, 重点研究了基于导演知识库的分层摄像机定性规划. 对于原版摄像机规划中, 随机生成的规划手法与场景主题联系不够紧密的缺陷, 在总结摄影领域相关理论研究的基础上, 利用语义网络技术建立摄像机导演知识库, 结合系统情节规划结果和系统的摄影领域知识设计实现摄像机定性规划的两层规则推导. 本文通过短信测试实验论证, 借助于引进构建的导演知识库和规则库, 基本可以实现摄像机拍摄方式的多样性和丰富性, 提高对于情节主题的表达能力. 本文摄像机导演定性规划应用基于知识的方法, 采用语义网本体和规则语言的方式形式化描述, 规则推理结果比较准确, 但领域知识覆盖面非常有限. 有限的规则与系统中日益增长的短信量对动画丰富性所需求的“无限”的摄像机拍摄手法之间的矛盾进一步加深, 因此对于知识库的构建需要不断的丰富, 相关的规则仍需要继续扩展.

| [1] |

Lu RQ, Zhang SM. Automatic Generation of Computer Animation. Berlin, Heidelberg, Germany: Springer, 2002.

|

| [2] |

Christie M, Machap R, Normand JM, et al. Virtual camera planning: A survey. Butz A, Fisher B, Krüger A, et al. Smart Graphics. SG 2005. Berlin, Heidelberg, Germany: Springer, 2005. 40–52.

|

| [3] |

Lino C, Christie M. Intuitive and efficient camera control with the toric space. ACM Transactions on Graphics, 2015, 34(4): 82.

|

| [4] |

Blinn J. Where am I? What am I Looking at? (cinematography). IEEE Computer Graphics and Applications, 1988, 8(4): 76-81. DOI:10.1109/38.7751 |

| [5] |

Phillips CB, Badler NI, Granieri J. Automatic viewing control for 3D direct manipulation. Proceedings of 1992 Symposium on Interactive 3D Graphics. New York, USA. 1992. 71–74.

|

| [6] |

Bares W, McDermott S, Boudreaux C, et al. Virtual 3D camera composition from frame constraints. Proceedings of the 8th ACM International Conference on Multimedia. Marina del Rey, CA, USA. 2000. 177–186.

|

| [7] |

李善平, 尹奇韡, 胡玉杰, 等. 本体论研究综述. 计算机研究与发展, 2004, 41(7): 1041-1052. |

| [8] |

Abele A, McCrae JP, Buitelaar P, et al. The linking open data cloud diagram. http://lod-cloud.net/. [2017].

|

| [9] |

Lehmann J, Isele R, Jakob M, et al. DBpedia-a large-scale, multilingual knowledge base extracted from Wikipedia. Semantic Web, 2015, 6(2): 167-195. |

| [10] |

潘旭光. 手机3D动画自动生成系统中摄像机规划的设计和实现[硕士学位论文]. 北京: 北京工业大学, 2013.

|

| [11] |

Daniel A. Grammar of the Film Language. Boston, MA, USA: Focal Press, 1976.

|

| [12] |

Katz SD. Film Directing Shot by Shot: Visualizing from Concept to Screen. Studio City, CA, USA: Michael Wiese, 1991.

|

| [13] |

The protégé project. https://Protege.stanford.edu. [2010-01-01].

|

| [14] |

Jhala A, Young RM. Cinematic visual discourse: Representation, generation, and evaluation. IEEE Transactions on Computational Intelligence and AI in Games, 2010, 2(2): 69-81. DOI:10.1109/TCIAIG.2010.2046486 |

| [15] |

Christie M, Olivier P, Normand JM. Camera control in computer graphics. Computer Graphics Forum, 2008, 27(8): 2197-2218. DOI:10.1111/j.1467-8659.2008.01181.x |

| [16] |

陆汝钤, 张松懋. 从故事到动画片——全过程计算机辅助动画自动生成. 自动化学报, 2002, 28(15): 321-348. |

| [17] |

Neches R, Fikes R, Finin T, et al. Enabling technology for knowledge sharing. AI Magazine, 1991, 12(3): 36-56. |

| [18] |

王曦. 动画自动生成系统中摄像机规划的研究[硕士学位论文]. 北京: 北京工业大学, 2007.

|

| [19] |

Octree. https://en.wikipedia.org/w/index.php?title=Octree&oldid=817035721. [2018-02-07].

|

| [20] |

Wilhelms J, Van Gelder A. Octrees for faster isosurface generation. ACM Transactions on Graphics (TOG), 1992, 11(3): 201-227. DOI:10.1145/130881.130882 |

| [21] |

Beno P, Pavelka V, Duchon F, et al. Using octree maps and RGBD cameras to perform mapping and A* navigation. Proceedings of 2016 International Conference on Intelligent Networking and Collaborative Systems. Ostrawva, Czech Republic. 2016. 66–72.

|

2018, Vol. 27

2018, Vol. 27