近年来三维运动捕获技术日趋成熟, 市场上生成了大量三维运动捕获系统, 该技术被应用于动画制作、影视特效、体育训练、医学仿真等领域之中.

文献[1–4]提出运动捕获从工作原理来划分, 主要分为: 机械式运动捕获、声学式运动捕获、电磁式运动捕获、光学式运动捕获和基于视频的运动捕获. 文献[5,6]提出了基于视频的运动捕获, 将人体模型从视频序列中分离出来后, 再通过传统的匹配算法匹配和重建. 该方法对于人体节点简易模型进行匹配效果较好, 但是对无模型的多点柔性物体效果并不理想. 文献[7]提出了一种基于稠密的重建方法, 对薄的物体进行重建, 效果较为理想, 但是对于稀疏的点状柔性物体并不适用. 文献[8]提出了一种基于图形硬件的点的曲面重构和可视化技术, 由于点不能很好地适应多边网格图形硬件, 所以效果一般且设备较昂贵. 文献[9]提出了一种无标记的服装变化运动捕获方法, 该方法基于多目立体视觉原理和多视图几何的关系来恢复服装的三维数据[10]. 该方法重建效果较好, 但会产生庞大的数据量, 因此处理起来极其复杂.

本文提出了一种基于双目视觉的点状特征柔性物体运动捕获方法, 该方法针对传统的SIFT算法[11,12]对较大的圆点匹配较困难的问题, 提出了一种改进的匹配方法. 该方法首先对柔性物体上的点状特征进行匹配, 再进行三维重建和时间序列上的匹配, 最终实现动态柔性物体的三维运动捕获.

1 特征提取第一步: 利用DOG方法进行角点检测[13], 如公式(1)所示. 首先利用不同的高斯核对图像进行卷积; 然后再进行归一化处理; 最后获得高斯差分后的图像. 经过高斯差分后的图像, 点状特征的边缘是暗的, 越靠近圆心越亮, 此结果表明圆心的灰度值最大.

| $\begin{aligned}f(x;\mu ,{\sigma _1},{\sigma _2}) = & \displaystyle\frac{1}{{{\sigma _1}\sqrt {2\pi } }}\exp \left( - \displaystyle\frac{{{{(x - \mu )}^2}}}{{2\sigma _1^2}}\right) \\ &-\displaystyle\frac{1}{{{\sigma _2}\sqrt {2\pi } }}\exp \left( - \displaystyle\frac{{{{(x - \mu )}^2}}}{{2\sigma _2^2}}\right)\end{aligned}$ | (1) |

第二步: 检测极值获取点状特征的圆心初始值. 以3×3的滤波器为例, 对图像中的每一个点进行遍历, 把这个点与其二维领域其他8个点进行比较, 如果其灰度值最大则为极大值, 然而有些极值并不是圆心, 而是圆心邻域的点, 将坐标值仅相差一个或两个像素范围的定位为同一圆心邻域的点, 再对同一邻域的点取均值从而获得精确的圆心.

2 特征匹配本文对传统的sift算法进行改进, 采用搜索策略来描述关键点. 首先, 经过立体标定和立体校正后[14,15], 按上节所述特征提取方法获取左右两幅图像的特征点坐标; 再分别比较单幅图像上前后坐标值是否重复, 通过取均值剔除掉重复点; 其次, 将左图像特征点坐标在一定像素范围的窗口上搜索右图像上相应匹配点的坐标, 该窗口可以如下公式(2)的形式表示:

| $\left\{\begin{array}{*{20}{c}}{\left| {x_i^m} - {x_{{j}}^m} \right| < \Delta \sigma _1^{{m}}}{\left| {y_i^m} - {y_{{j}}^m} \right| < \Delta \sigma _2^{{m}}}\end{array}\;\;\;(i,j = 1,2,3,\cdots)\right.$ | (2) |

其中, 在第m帧的时刻, 左图像上像素点用(xi, yi)表示, 右图像上像素点用(xj, yj)表示, 若左图像上的像素坐标与右图像上的像素坐标能在给定的阈值σ1×σ2窗口内, 则分别给左右图像的匹配点坐标一个索引序号, 即每个匹配对将有唯一的标识; 最后, 通过绘制关键点方法匹配所有点状特征的圆心, 本文根据实验结果得出结论, 相比于传统的SIFT算法[12]和SURF算法[16]对较大的圆点特征提取率极低, 匹配效果不理想, 本文方法大大提高了匹配精准度.

3 重建 3.1 空间上的重建世界坐标系转换成图像坐标系经过了刚体变换和透视投影变换, 而三维重建是该过程的一个逆向操作, 因此可以通过图像坐标和投影矩阵反向求解出匹配点的三维空间坐标. 由于本文是建立在基于双目立体视觉的基础上, 所以只需要考虑两台摄像机的相对位置关系, 如果把左相机坐标系当作世界坐标系, 则投影矩阵可由公式(3)表示:

| $\begin{array}{l}{{\rm P}_1} = {{\rm K}_1}[{\rm I}|0]\\{{\rm P}_2} = {{\rm K}_2}[{\rm R}|{\rm T}]\end{array}$ | (3) |

其中K为内参数矩阵, R为旋转矩阵, T为平移矩阵. 左投影矩阵P1可以进一步分解为P11, P12, P13, 如公式(4)所示的形式:

| $S\left[ {\begin{array}{*{20}{c}}{{u_i}}\\{{v_i}}\\1\end{array}} \right] = \left[ {\begin{array}{*{20}{c}}{{{\rm P}_{11}}}\\{{{\rm P}_{12}}}\\{{{\rm P}_{13}}}\end{array}} \right]{\tilde X_i} \Rightarrow \left[ {\begin{array}{*{20}{c}}{{{\rm P}_{13}}{u_i} - {{\rm P}_{11}}}\\{{{\rm P}_{13}}{v_i} - {{\rm P}_{12}}}\end{array}} \right]{\tilde X_i} = 0$ | (4) |

而左图像的任意匹配点i齐次坐标为

| $\left[ {\begin{array}{*{20}{c}}{{{\rm P}_{13}}{u_i} - {{\rm P}_{11}}}\\{{{\rm P}_{13}}{v_i} - {{\rm P}_{12}}}\\{{{\rm P}_{23}}{{u'}_i} - {{\rm P}_{21}}}\\{{{\rm P}_{23}}{{v'}_i} - {{\rm P}_{22}}}\end{array}} \right]{\tilde X_i} = 0$ | (5) |

由公式(5)可知, 四个方程求解三个未知数, 通过最小二乘法原理求解出

| ${\rm {A = US{V^T}}}$ | (6) |

再对A进行奇异值分解[17], 则

对点状特征柔性物体的运动轨迹进行时间上的重建, 步骤如下:

第一步, 利用已获取的当前帧图像的二维坐标, 在一定像素范围的小窗口内搜寻下一帧相应的坐标, 如公式(7)所示:

| $\left\{\begin{array}{*{20}{c}}{x_i^m - \Delta \sigma < x_i^{m + 1} < x_i^m + \Delta \sigma }\\{y_i^m - \Delta \sigma < y_i^{m + 1} < y_i^m + \Delta \sigma }\end{array}\;\;\;(i = 1,2,3,\cdots)\right.$ | (7) |

第二步, 同理, 在右图像上找到目标点连续帧内的坐标.

第三步, 将左右图像时间上连续的坐标进行匹配重建, 就可以获得该点在时间上连续的空间坐标.

按PAL标准1 s分为25帧, 所以两帧之间的时间就是Δt, 两帧之间运动的距离为ΔS, 如公式(8)所示:

| $\left\{\begin{array}{l}\Delta s = \sqrt {{{({x_1} - {x_2})}^2} + {{({y_1} - {y_2})}^2} + {{({z_1} - {z_2})}^2}} \\[5pt]\Delta t = \displaystyle\frac{1}{{24}}s\end{array}\right.$ | (8) |

因此可以得到目标点在两帧之间运动的速率Δv, 由公式(9)所示. 同理也可以通过速率求得加速度Δa如公式(10).

| $\quad\quad\quad\quad\quad\quad\left.\begin{array}{*{20}{c}}\Delta v = \displaystyle\frac{{\Delta s}}{{\Delta t}}\quad\quad\quad\quad\quad\quad\quad\quad\quad\quad\quad(9)\\[5pt]\Delta a = \displaystyle\frac{{\Delta v_{i + 1}^2 - \Delta v_i^2}}{{2\Delta s}}\quad\quad\quad\quad\quad\quad\quad(10)\end{array}\right.$ |

本文进行了三组实验分别针对:布满点状特征的白纸、布满点状特征的服装以及画有点状特征的人脸, 采用两台型号为SONY FDR-AX30的高速摄像机拍摄运动视频, 再经过立体标定, 立体校正, 特征点匹配, 三维重建等过程, 最终实现动态柔性物体的三维运动捕获, 并用Meshlab重建三维空间点效果图.

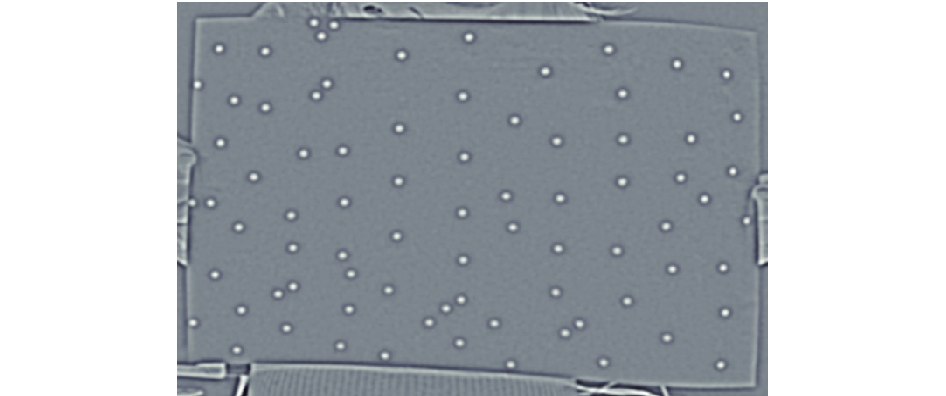

4.1 实验结果分析本实验的实验对象分别如图1(a)点状特征的白纸、图1(d)点状特征的服装、图1(g)点状特征的人脸所示, 图1(b)、图1(e)和图1(h)是重建结果的正视图, 图1(c)、图1(f)和图1(i)是相应的侧视图. 经分析图片可以清晰地看到柔性物体表面的点状特征在某一时刻的三维空间位置被精准地重建出来, 因此说明本文对于点状柔性物体的三维运动捕获方法效果比较理想.

|

图 1 三维重建效果图 |

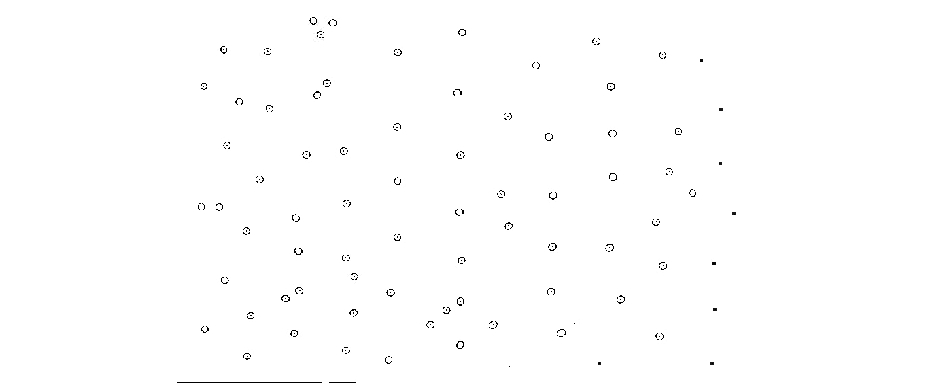

本实验将DOG方法与最小二乘法拟合椭圆的方法[18]作比较. 图2为DOG角点检测图, 图3为椭圆拟合的结果, 圆中亮点为特征点圆心位置; 图4为图3中右下角某点状特征放大图. 首先, 因为DOG获得的是与特征点相同的圆, 而椭圆拟合获取的是与特征点类似的椭圆, 所以DOG方法获得的圆心理论上更接近精准圆心位置. 其次, 图4中灰色的点为DOG方法获得的圆心位置, 黑色的点为椭圆拟合方法获得的圆心位置, 图中黑色的点偏离了灰色点, 并且不在圆内的灰色点则为椭圆拟合没有检测到的圆心位置, 此结果表明DOG获取的特征点位置更加精准.

|

图 2 DOG角点检测 |

本文通过DOG方法检测特征点, 再对检测到的特征点运用搜索策略进行特征匹配. 如图5(a)是在经过DOG检测特征点后, 利用搜索策略进行特征匹配的效果图. 本文不仅给出了搜索策略的匹配效果图, 还对sift算法和surf算法进行了实验, 图5(b)和图5(c)分别是两方法的匹配效果图, 经过对实验结果的比对, 发现本文的匹配方法更加理想和精准, 说明了本文方法对于较大的点状特征提取率高且匹配更加精准.

|

图 3 椭圆拟合获取特征点 |

|

图 4 圆心坐标比对效果图 |

如图6所示, 是白纸上9个点在连续15帧内的运动轨迹. 图6(a)是在柔性物体上选取9个目标点并进行标注, 图6(b)是这9个点在15帧内的运动轨迹正视图, 图6(c)是相应的俯视图. 从图6(b)和图6(c)可看出, 图7的目标点是在进行前后运动的, 个别点运动的幅度大, 个别运动的幅度小. 总体上是在进行前后运动的趋势, 实现了目标点在时间上运动轨迹的重建.

|

图 5 特征点检测与匹配效果图 |

假设某点的三维空间坐标为(X, Y, Z), 如表1所示是图6(a)中1号点的前5帧空间坐标. 表2是对应的速度和加速度数据. 从表格中的数据可以看出该点前五帧的运动趋势是先加速再减速, 即可以预测该点处于在前后抖动的运动趋势.

4.2 人脸表情应用本实验对画有点状特征的人脸进行三维运动捕获, 重建结果如图1(h), 1(i)所示. 本实验通过计算点的速度、加速度分析点的运动趋势.

如图7所示, 本文用黑色箭头表示第一帧到最后一帧的运动趋势. 图7(a)是人脸做出微笑表情时点的运动趋势, 如图所示微笑的时候嘴唇和脸颊周围的点呈上升趋势, 而鼻子额头上的点呈下降趋势. 图7(b)是人脸做出大笑表情时点的运动趋势, 如图所示上嘴唇、脸颊、鼻子、额头上的点都呈上升趋势, 而只有下嘴唇和下巴上的点呈下降趋势. 图7(c)是人脸做出惊讶的表情, 如图所示唇部与大笑表情几乎一样的运动趋势, 但是有一个很大的区别就是两嘴角却是向内收敛的运动趋势. 图7(d)是人脸做出愤怒的表情, 如图所示与其他表情不一样, 该图中脸部的点都在做呈向上运动的趋势, 上下嘴唇中间点, 先向下运动再向上运动回到原点.

|

图 6 目标点连续15帧空间运动轨迹 |

|

图 7 人脸表情上点运动趋势图 |

| 表 1 1号点的前五帧坐标(单位: mm) |

| 表 2 1号点前五帧的速度和加速度 |

在图7人脸数据中选取上嘴唇中间点和下嘴唇中间点, 分别用up和down表示. 表3记录了这两个点在图7所示四种表情的首. v_end, a_start, a_end分别代表特征点首帧速度, 尾帧速度, 首帧加速度, 尾帧加速度. 如表3所示, 图7(b)的速度值比图7(a)大, 加速值比其小, 说明人在大笑时唇部肌肉运动的速度比微笑时快, 但速度的变化比微笑时慢, 从而表明了人大笑时面部表情比微笑时保持得更久; 图7(c)的速度值比图7(b)大, 加速度值比其大, 说明人在惊讶时唇部肌肉运动速度比大笑时快, 而且速度变化得快, 从而表明了这个表情在一瞬间产生; 图7(d)的速度值均偏小, 说明人在生气时, 唇部肌肉运动的速度慢, a_up的值较大表明上嘴唇上方的肌肉运动速度变化较快, a_down的值为负数说明下嘴唇下方的肌肉从开始时运动很快又立即变慢.

| 表 3 点up和down速度加速度 |

5 结论

本文提出了一种实用的基于点状特征的柔性物体运动捕获方法. 实验结果显示, DOG方法比椭圆拟合方法获取特征点的位置更加精准; 采用搜索策略实现匹配, 相比传统的SIFT算法, SURF算法大大提高了匹配精准度. 此外, 在三维重建的基础上进行扩充, 增加时间序列上的匹配, 从而实现动态柔性物体的三维运动捕获, 其次通过分析速度、加速度等数据来应用到人脸表情分析, 为后期用动态数据驱动静态图像打下基础.

| [1] |

向泽锐, 支锦亦, 徐伯初, 等. 运动捕捉技术及其应用研究综述. 计算机应用研究, 2013, 30(8): 2241-2245. |

| [2] |

李晓丹, 肖明, 曾莉. 人体动作捕捉技术综述以及一种新的动作捕捉方案陈述. 中国西部科技, 2011, 10(15): 35-37. DOI:10.3969/j.issn.1671-6396.2011.15.018 |

| [3] |

梁丰, 张志利, 李向阳, 等. 基于光学运动捕捉数据的虚拟人下肢运动控制方法. 系统仿真学报, 2015, 27(2): 327-335. |

| [4] |

Luo Q. Research on motion capture instruments in sports. Applied Mechanics and Materials, 2013, 346: 151-155. DOI:10.4028/www.scientific.net/AMM.346 |

| [5] |

罗忠祥, 庄越挺, 潘云鹤, 等. 基于视频的运动捕获. 中国图像图形学报, 2002, 7(8): 752-758. |

| [6] |

庄越挺, 刘小明, 潘云鹤, 等. 运动图像序列的人体三维运动骨架重建. 计算机辅助设计与图形学学报, 2000, 12(4): 245-250. |

| [7] |

Ummenhofer B, Brox T. Point-based 3D reconstruction of thin objects. Proceedings of the 2013 IEEE International Conference on Computer Vision. Sydney, NSW, Australia. 2013. 969–976.

|

| [8] |

Boubekeur T, Reuter P, Schlick C. Visualization of point-based surfaces with locally reconstructed subdivision surfaces. Proceedings of the 2005 International Conference on Shape Modeling and Applications. Cambridge, MA, USA. 2005. 23–32.

|

| [9] |

Bradley D, Popa T, Sheffer A, et al. Markerless garment capture. ACM Transactions on Graphics (TOG), 2008, 27(3): 99. |

| [10] |

Seitz SM, Curless B, Diebel J, et al. A comparison and evaluation of multi-view stereo reconstruction algorithms. Proceedings of the 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. New York, NY, USA. 2006. 519–528.

|

| [11] |

Peng KJ, Chen X, Zhou DX, et al. 3D reconstruction based on SIFT and Harris feature points. Proceedings of the 2009 IEEE International Conference on Robotics and Biomimetics (ROBIO). Guilin, China. 2009. 960–964.

|

| [12] |

Lindeberg T. Scale invariant feature transform. Scholarpedia, 2012, 7(5): 10491. DOI:10.4249/scholarpedia.10491 |

| [13] |

王青松, 赵西安, 吕京国, 等. 基于高斯差分的改进Harris特征点提取算法. 测绘科学, 2014, 39(4): 119-122, 134. |

| [14] |

Zhang Z. A flexible new technique for camera calibration. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11): 1330-1334. DOI:10.1109/34.888718 |

| [15] |

陈蓉, 罗晓曙. 一种基于双目立体视觉的图像校正算法设计. 测控技术, 2016, 35(5): 16-19, 24. |

| [16] |

Wang XL, Yang L, Wang LR, et al. Characteristic point match algorithm based on the SURF in binocular stereo vision. Proceedings of the 5th International Conference on Intelligent Networks and Intelligent Systems (ICINIS). Tianjin, China. 2012. 302–305.

|

| [17] |

Cui YM, Wang H, Zhang J. 3D restructuring and splicing technology of shape space frame. Applied Mechanics and Materials, 2014, 644–650: 1438-1442. DOI:10.4028/www.scientific.net/AMM.644-650 |

| [18] |

马向南, 李航, 刘丽丽, 等. 最小二乘改进算法及其在椭圆拟合中的应用. 河南科技大学学报: 自然科学版, 2014, 35(3): 18-21. |

2018, Vol. 27

2018, Vol. 27